台北西門町宵夜新選擇!「ABV串串啤酒館」新開幕,主打麻辣串串火鍋搭配啤酒雪花冰,小編發現這家店把麻辣和冰涼的啤酒完美結合,推出特製啤酒雪花冰,創新吃法讓人眼睛一亮!喜歡吃宵夜的朋友有福了,這裡從晚餐到凌晨3點都營業,串串只要15元起,經典賓士鍋每人180元,加上工業風空間設計,正適合三五好友相約小酌。下載食尚APP,天天免費抽大獎!

全新「ABV串串啤酒館」插旗西門

全台擁有多家連鎖知名餐酒館「ABV餐飲集團」,成立於2015年,致力於推廣精釀啤酒的品飲文化,結合世界各地特色料理與傳統美食。目前集團旗下共有7大餐飲品牌,包括美式料理、日式料理、地中海料理、川渝美食等,滿足不同口味的饕客。這次推出全新品牌「ABV串串啤酒館」,主打道地的麻辣串串火鍋及多款江湖菜,地點就選在熱鬧的西門商圈,從捷運西門站6號出口,步行約8分鐘即可抵達,交通相當便利。

▲全台擁有多家連鎖知名餐酒館「ABV餐飲集團」,成立於2015年,致力於推廣精釀啤酒的品飲文化。(張庭瑄 攝)【禁止酒駕 未滿18歲禁止飲酒】

▲「ABV串串啤酒館」主打正宗重慶口味的麻辣串串火鍋。(張庭瑄 攝)

▲地點就選在熱鬧的西門商圈,從捷運西門站6號出口,步行約8分鐘即可抵達。(張庭瑄 攝)

道地重慶麻辣串串火鍋

「ABV串串啤酒館」主打正宗重慶麻辣串串,饕客可以先挑選「經典賓士鍋」(每人180元)鍋底口味,包括招牌牛油麻辣鍋、豬油麻辣鍋、酸菜金湯鍋、膠原蛋白養生鍋和七彩菌菇養生鍋等6種選擇。而湯底辣度分級從「台灣辣」到「重慶辣」都有,嗆辣油香十足,入口後麻中帶辣、香氣四溢,嗜辣者可以挑戰看看!

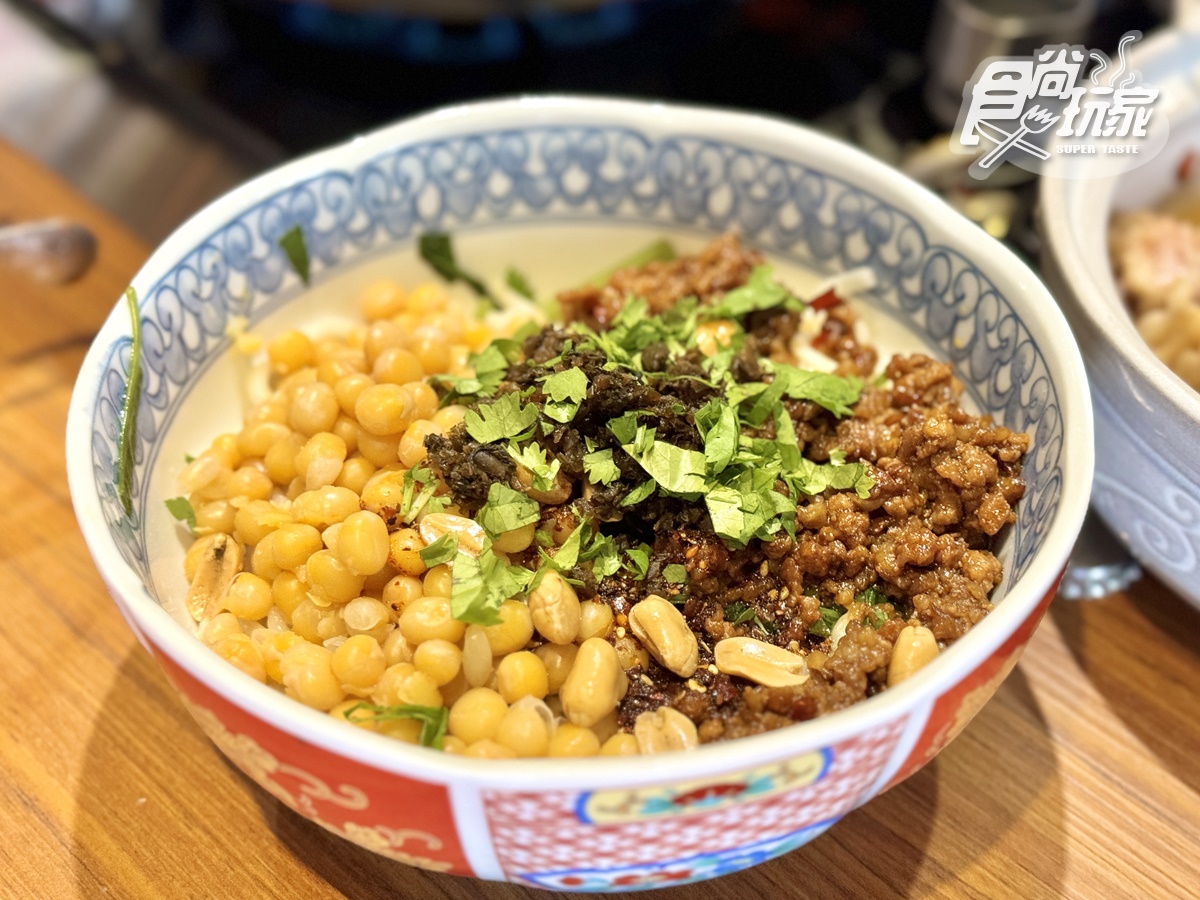

▲串串是一種將各種食材如肉類、蔬菜、海鮮等串成一串,放入滾燙的麻辣湯底或清湯中涮煮的飲食方式。(張庭瑄 攝)

▲湯底辣度分級從「台灣辣」到「重慶辣」都有,嗆辣油香十足。(張庭瑄 攝)

看更多:對中「這2碼」免費送牛舌!桃園超狂「火鍋吃到飽」888元和牛+干貝海鮮無限吃

串串每支15元起 超過50款選擇

最吸引人的是,每支串串只要15元起,價格相當親民。自助區火鍋串串選擇豐富,多達50款種類,包括以祕製香料醃漬的肉類、海鮮、蔬菜、豆製品、火鍋料等等,應有盡有。小編特別推薦肉品類的滷牛筋、滷大腸、十三香牛肉條,口感入味且香氣十足;蔬菜與鍋物類則不能錯過綠櫛瓜、玉子燒和各式餃類。

▲自助區火鍋串串選擇豐富,多達50款種類,包括以祕製香料醃漬的肉類、海鮮等。(張庭瑄 攝)

▲還有多款海鮮料可以選擇。(張庭瑄 攝)

肉控必點牛小排、小酥肉

如果是肉肉控,可以加點肉盤類「無骨牛小排」(480元)和「松阪豬肉片」(320元),Q彈滑嫩超唰嘴。而江湖菜推薦「川渝口水雞」(260元)選用嫩滑雞肉,淋上紅油、花椒與獨門香料;「小酥肉」(160元)外皮炸至金黃酥脆,一口咬下香而不膩;「乾鍋臘味土豆」(280元)將臘肉的濃郁煙燻香氣與鬆軟土豆完美結合,鹹香夠味。

▲如果是肉肉控,可以加點肉盤類或是多款江湖菜。(張庭瑄 攝)

▲多款江湖菜獨特的風味和豐富的口感,每款都經典好吃。(張庭瑄 攝)

獨特啤酒雪花冰超驚豔

最特別的甜點「啤酒雪花冰」,可以挑選喜愛的啤酒款式加價製作,搖身一變成專屬的雪花冰,製作過程療癒感十足,看著雪花冰逐漸成形,最後還能挑選3種配料增添層次,獨特啤酒香口感綿密清爽,搭配新鮮水果更是一絕,讓人從視覺到味覺都獲得雙重享受。而「重慶冰粉」(180元)和「糖油果子」(160元)則帶來道地川渝甜點風味,外皮金黃酥脆、內裡軟糯Q彈。

▲可以挑選喜愛的啤酒款式加價製作,搖身一變成專屬的雪花冰。(張庭瑄 攝)【禁止酒駕 未滿18歲禁止飲酒】

▲「重慶冰粉」(180元)也是甜點控不能錯過的美食之一。(張庭瑄 攝)

▲體驗到精釀啤酒的多層次風味,多款來自世界各地的精釀啤酒進行搭配。(張庭瑄 攝)【禁止酒駕 未滿18歲禁止飲酒】

▲店內還有沾料可以自行搭配,也有推薦的涮煮時間可以參考。(張庭瑄 攝)

【禁止酒駕 未滿18歲禁止飲酒】

原文轉載來自:來源連結