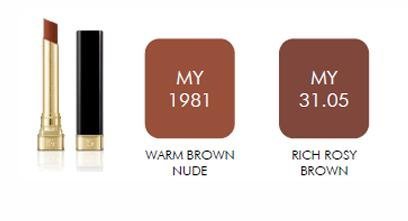

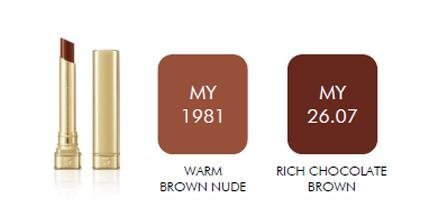

Pantone 2025年代表色「摩卡慕斯Mocha Mousse」出爐後便吹起一股Mocha Mousse Makeup的風潮,透過豐富而溫暖的棕色調,打造低調優雅的氛圍。在眼影與頰彩部分,可以選用【DG超持色眼頰兩用彩盤(修容色)】設計靈感源自摩洛哥皮革布料,展現精緻高級的裸棕古銅色調,打造被陽光親吻過的自然色澤。總共有5種時尚色選,絲滑、輕盈,可輕鬆暈染疊加,妝感服貼保濕度高,可做為修容與眼影的多用途使用。在脣膏部分,可以搭配【DG 唯我脣膏】的【DG 唯我絲絨霧光脣膏1981】、【DG 唯我絲絨霧光脣膏31.05】或是【DG 唯我絲緞釉光脣膏1981】、【 DG 唯我絲緞釉光脣膏26.07】。如果希望為整體大地色系妝容增添光採,也可以搭配【DG 摯愛美肌無瑕亮彩餅】於鼻頭、顴骨、眉骨等部位做打亮,打造服貼精緻閃耀妝感,綻放自然光澤。

【DG超持色眼頰兩用彩盤(修容色)】

內涵義大利覆盆子和葡萄,改善皮膚屏障並幫助保持皮膚水分,妝感服貼自然

杜嘉班納

超持色眼頰兩用彩盤(修容色)

【DG 唯我脣膏】

內含玻尿酸,先保濕再鎖色,顯色持久,細緻質地宛如第二層肌膚般服貼舒適,維持高度輕盈舒適,靈感源自義大利建築柱;以極細管身展現絕佳握感與時尚外觀,完美貼合脣瓣,輕鬆勾勒出多維度3D脣妝。

備註: 1981的色號名稱為紀念品牌兩位設計師STEFANO GABBANA 和DOMENICO DOLCE 第一是見到彼此的年份

杜嘉班納

唯我絲絨霧光脣膏

杜嘉班納

唯我絲緞釉光脣膏

標題:【Dolce & Gabbana】Pantone 2025年度代表色「摩卡慕斯」,以DOLCE&GABBANA BEAUTY彩妝打造時尚摩卡妝容! LET’S GLOW UP DG MOCHA LOOK! /

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。