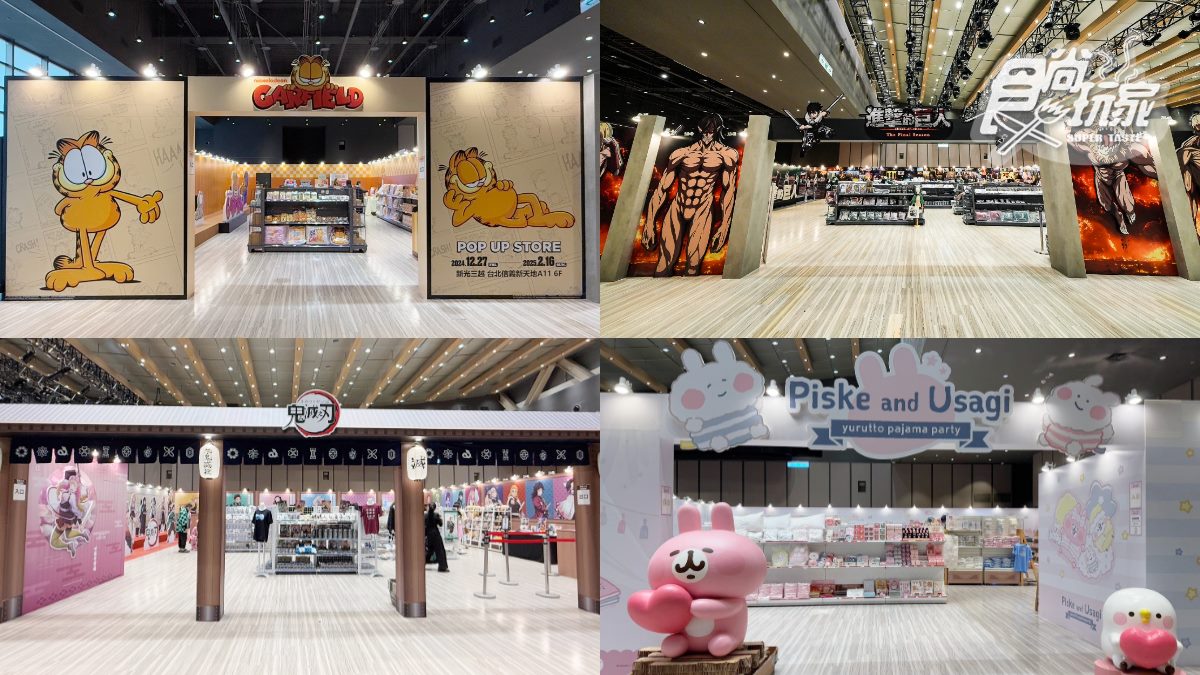

動漫迷們有福了~台北信義區一次迎來4大人氣動漫快閃店,從即日起~2025/2/16在信義新天地A11的6樓限時展出!無論是喜愛療癒系的卡娜赫拉、慵懶可愛的加菲貓、熱血沸騰的鬼滅之刃、或是潮到讓人想「獻出錢包」的進擊的巨人,通通能一次逛!每個快閃店都設置了獨特的打卡點,讓粉絲們能拍出最吸睛的美照,還有滿滿的最新款周邊商品,絕對讓大家荷包守不住!下載食尚APP,天天免費抽大獎!

4大快閃店一次看

想一次逛遍多個動漫角色快閃店的朋友一定要衝!台北信義新天地A11於6樓一次集結4大超人氣快閃店,從即日起~2025/2/16期間展開,包括卡娜赫拉的小動物、加菲貓、鬼滅之刃、進擊的巨人主題店,不僅有超過百款周邊商品,還有超多打卡點,讓粉絲們拍到手軟!4大快閃店消費滿額還會送限量周邊,動漫迷快把這篇收藏起來~

▲台北信義新天地A11於6樓一次集結4大超人氣快閃店,包括加菲貓、進擊的巨人、鬼滅之刃、卡娜赫拉的小動物等主題店。(許瑋芯 攝)

01. 卡娜赫拉:睡衣派對系列超軟萌

8大晚安系打卡點

快和P助與粉紅兔兔開趴踢!「卡娜赫拉的小動物-睡衣派對」推出8大晚安系拍照打卡點,就從在門口抱著愛心迎接大家的「立體P助與粉紅兔兔」開拍,接著再到「睡前儀式區」和梳頭的粉紅兔兔與照鏡子的P助甜蜜合照,別忘了旁邊還有著暖暖床和頭戴睡帽的P助、身穿毛絨絨睡衣的粉紅兔兔。最後,「巨型扭蛋機」不只可以試試手氣更能滿足拍照慾望!

▲卡娜赫拉的小動物快閃店以「睡衣派對」為主題,打造8大拍照打卡點。(許瑋芯 攝)

鬆軟系抱枕、枕頭套

現場推出有著睡衣裝扮的P助與粉紅兔兔的枕頭套、眼罩、睡衣、抱枕、毛毯等晚安商品,整套買回家讓大家一夜好眠!氣溫逐漸下降,就讓躺躺談心、蓋被被入睡2款材質鬆軟毛毯對抗寒流吧。粉絲必收的還有2款P助與粉紅兔兔穿著粉、黃色條紋睡衣抱枕,上頭的立體蝴蝶結和球球太可愛!活動期間單筆消費滿888元即可獲得限量「睡衣派對紙膠帶」。

▲店內周邊商品包括超大蝴蝶結造型大抱枕、兔兔P助洗臉髪帶、眼罩等。(許瑋芯 攝)

▲也有各式盲盒、娃娃等。(許瑋芯 攝)

「卡娜赫拉的小動物-睡衣派對」快閃店

展覽日期:即日起~2025/2/16

展覽地點:台北市信義區松壽路11號6樓(新光三越台北信義新天地A11 6樓)

營業時間:週一至四、日11:00~21:30/週五、六 11:00~22:00(依百貨營業時間為主)

看更多:免費送2025桌曆!JOGUMAN主題展免費打卡,100款周邊、聯名餐點一次看

02. 加菲貓:百變加菲貓一次收

調皮搗蛋3大打卡點

各位加菲貓迷久等了~「加菲貓快閃店」滿滿3大拍照打卡點保證怎麼拍都出片!一進店就可看到「主視覺區」肚子大大、懶散側躺的加菲貓,接著來到比讚咧嘴笑、招招手和眨眼放電的「三大表情包區」,最後是把愛吃、懶惰、調皮、厭世和愛睡通通集結的「百變加菲貓區」,每一區都一定要合照的呀!

▲進到店內就可以看到聚集各種耍廢、調皮舉動的「百變加菲貓區」,每一區都要拍好拍滿才行。(許瑋芯 攝)

▲店內也有拍貼機、姓名貼機等。(許瑋芯 攝)

100款全新周邊

快閃店更推出超過100款全新周邊商品,讓大家買到剁手手!從角色大臉造型馬克杯,到加菲貓流沙杯墊全都不能錯過,還有印有滿滿加菲人生哲學的抱枕,通通要帶回家!現場還有保溫瓶、冷水瓶、飲料提袋等超實用品項,活動期間單筆消費滿888 元即可獲得徽章,粉絲們預備備衝刺啦!

▲加菲貓快閃店帶來超過百款獨家周邊商品,從樂高、糖果系主題療癒抱枕、加菲貓盲盒、T恤等都有。(許瑋芯 攝)

▲超實用周邊像是角色大臉造型馬克杯、療癒流沙杯墊、保溫杯等通通要收。(許瑋芯 攝)

「加菲貓」快閃店

展覽日期:即日起~2025/2/16

展覽地點:台北市信義區松壽路11號6樓(新光三越台北信義新天地A11 6樓)

營業時間:週一至四、日11:00~21:30/週五、六 11:00~22:00(依百貨營業時間為主)

03. 鬼滅之刃:日式建築外型神還原

15位熱門角色都要拍

台北鬼滅迷衝場時間到!「鬼滅之刃」快閃店以日式建築外型歡迎各位到來,現場推出6大打卡點,就從「主視覺打卡牆」開始,身旁還有炭治郎、禰豆子、善逸、伊之助及音柱的3位老婆等角色。集結九柱擺出帥氣動作的「九柱畫報區」,每個角色的獨特魅力全都在這!接著再到「戀之呼吸打卡牆」,跳起來揮舞日輪刀的戀柱,充滿自信的笑容肯定要來拍1張,店裡左邊還有集結了九柱等15位熱門角色「全員集合」,每位都要合照1張才能走啊!

▲鬼滅之刃快閃店以日式建築為主題,打造6大打卡區,集結15位人氣角色。(圖片來源:信賴互動、許瑋芯 攝)

滿999元送限量磁鐵

快閃店更推出霞柱、戀柱、炎柱、音柱及蟲柱等九柱周邊,從超有收藏價值的簽名色版、雙人立牌,到實用的行動插頭、滑鼠墊、壓克力鑰匙圈通通都有!不只消費更要拿滿額禮!店內單筆消費滿999元就可獲得鬼滅之刃磁鐵,吸在冰箱或白板上都好看,有總是不放棄的炭治郎、咬著竹筒的禰豆子、沒自信卻強大的善逸及帶著山豬頭套的伊之助,除了4位主要角色外還有寫著滅的鬼殺隊款式,想要加入鬼殺隊就趁現在!

▲店內推出百款精美商品,包括刀匠村篇無框畫、流沙立牌、Q版鑰匙圈、LED燈、耳飾架、滑鼠墊等。(許瑋芯 攝)

「鬼滅之刃」快閃店

展覽日期:即日起~2025/2/16

展覽地點:台北市信義區松壽路11號6樓(新光三越台北信義新天地A11 6樓)

營業時間:週一至四、日11:00~21:30/週五、六 11:00~22:00(依百貨營業時間為主)

04. 進擊的巨人:最後一場決戰超熱血

5大打卡點拍好拍滿

最後的最後一場決戰!「進擊的巨人:Final Season」快閃店店外就可看到超大型巨人、女巨人、進擊的巨人、鎧甲巨人、顎之巨人及野獸巨人等6位巨人在「巨人打卡區」一字排開。走進店內整面「動畫回顧牆」帶大家重溫劇情及最後一戰的震撼,右邊則有超越時空的異空間「道路」,快來這與始祖尤米爾精神連結吧!

往左邊來到「決戰大扭蛋」,讓人立刻想起艾連與萊納戰鬥中互毆的熱血片段,旁邊還有著戰鎚巨人、野獸巨人、顎之巨人及調查兵團等參與決戰的角色們,一定要來顆熱血大扭蛋!最後是「調查兵團與席納之牆」艾蓮、米卡莎、阿爾敏、里維、漢吉等9位全力奮戰為自由而戰的角色都在這,一起到席納之牆前與他們合照吧!

▲巨人迷絕不能錯過的進擊的巨人快閃店,特別打造超大、超高的巨人打卡牆,還有動畫回顧照片牆,讓粉絲重溫經典場景。(圖片來源:信賴互動)

▲粉絲們不能錯過「霞柱大扭蛋」,豐富的獎品等待大家試試手氣。(許瑋芯 攝)

60款最新周邊超帥氣

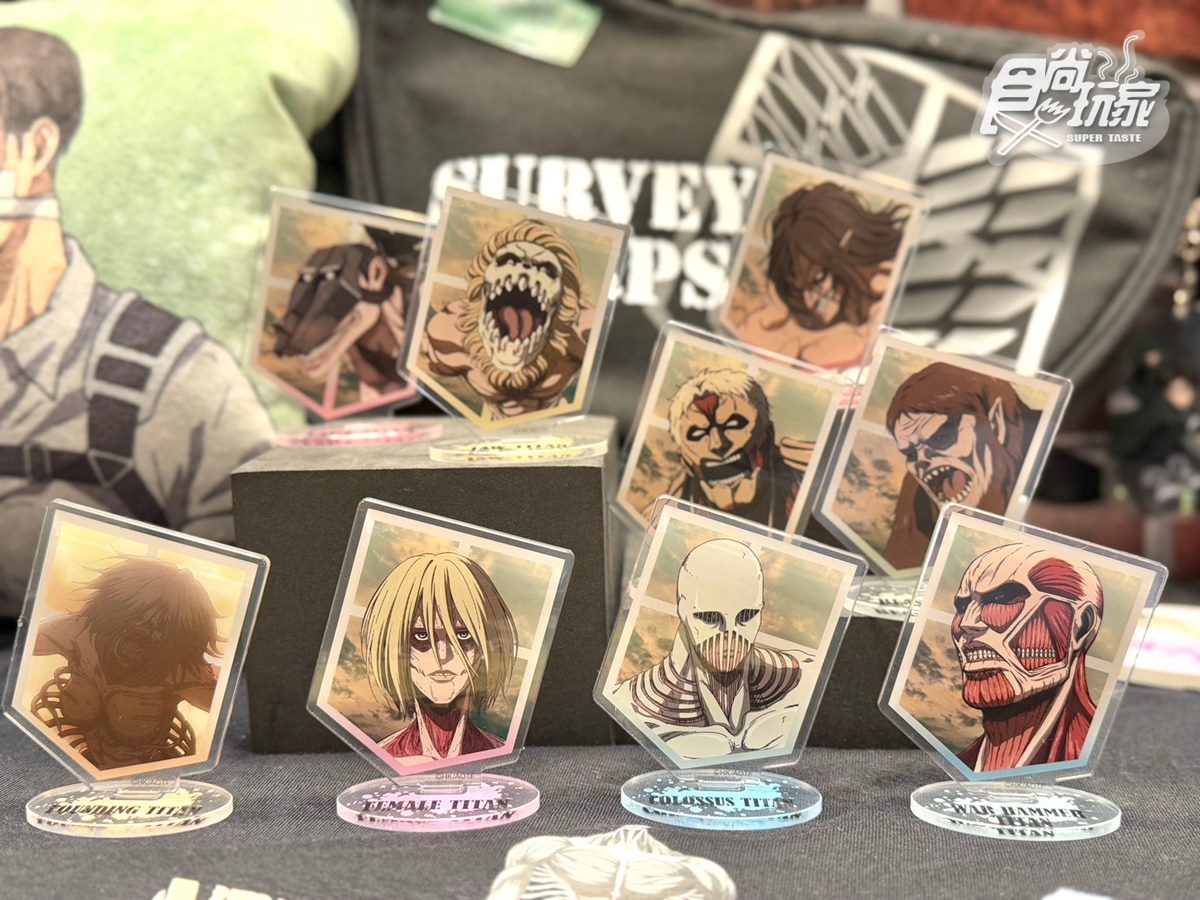

店內推出近60款最新周邊,讓人愛不釋手的盲抽系列推出進擊的巨人、超大型巨人、女巨人等9大巨人壓克力立牌,2張「進擊的巨人The Final Season」無框畫,粉絲一定要買來布置家裡!通勤族必備ID卡套黑色底搭配自由之翼及角色們帥氣的模樣,上課或上下班一定要帶出門。另外也有流沙壓克力鑰匙圈、T-shirt、長方鏡、長門簾等,讓生活中都有進擊的巨人的身影,消費滿999元再送限量Q版角色年曆,每個月份有不同的角色!

▲店內推出近60款周邊商品,包括自由之翼防水披風、角色立牌、鋁合金杯墊,以及多款調查兵團披風,讓粉絲化身調查兵團成員。(許瑋芯 攝)

「進擊的巨人:Final Season」快閃店

展覽日期:即日起~2025/2/16

展覽地點:台北市信義區松壽路11號6樓(新光三越台北信義新天地A11 6樓)

營業時間:週一至四、日11:00~21:30/週五、六 11:00~22:00(依百貨營業時間為主)

原文轉載來自:來源連結