▲「元利四季莊園」空拍圖。

圖、文/新聯陽實業提供

在台北市繁華都心,千坪基地已難得,萬坪基地更稱得上鳳毛麟角。台灣一線建商元利建設歷經十餘年醞釀,終於在2024年第三季,於文山區木柵路一段,推出面積逾12,000坪的「元利四季莊園」市心型造鎮大案,磅礡尺度不僅全台罕見,更是集團首屈一指的年度鉅作。個案除了緊鄰10.8公頃仙跡巖(景美山),同時還與12,600坪木柵公園地界構連,形成「萬坪社區」疊加「萬坪公園」的超廣域尺度,還能從社區裡直接散步到公園,家彷彿蘊藏一座城市園林,享有極致奢華的俬苑綠域,堪稱城市裡的居住烏托邦。

▲基地緊鄰日後的捷運環狀線南環段Y4站。

南環段動工在即 捷運題材加值木柵

「元利四季莊園」為木柵路一段、光輝路、下崙路所圍的全街廓鉅型開發,因地處木柵繁華位置,開車經信義快速道路,平均約15分鐘可迅抵大安與信義區。此外周邊生活機能也極便利,像是坐擁三快聯外道路,並享有中山、永建、再興等多所明星小學學區資源。至於交通遠景上,捷運環狀線南北環段將於2025年Q1動工,基地距南環段Y4站僅400米之遙,再加上軌道路線串連東環段,日後可直達信義與內湖,同頻信義計畫區和內科的跨區生活圈利多,讓木柵價值應聲翻漲。

▲「元利四季莊園」建築外觀3D情境示意圖。

複合造鎮超享受 休閒、採買、交通all in one

受惠於廣袤基地的先天優勢,「元利四季莊園」還導入住、商、藝、遊、行等共鑄一體的多核心機能。包括規劃一樓沿街店面、打造面積高達2,500坪且總計超過30項的休閒娛樂設施;此外,社區還將設置接駁專車,日後可串連捷運辛亥站、市政府站、台北101/世貿站,暢行台北市各大繁華節點。這座挹注十多年籌備的複合造鎮社區,涵蓋日常多維度需求,「all in one 全生活體驗」的超居住豐富性,是元利建設用「待如家人」心念,真摯打造的都會優質好宅。

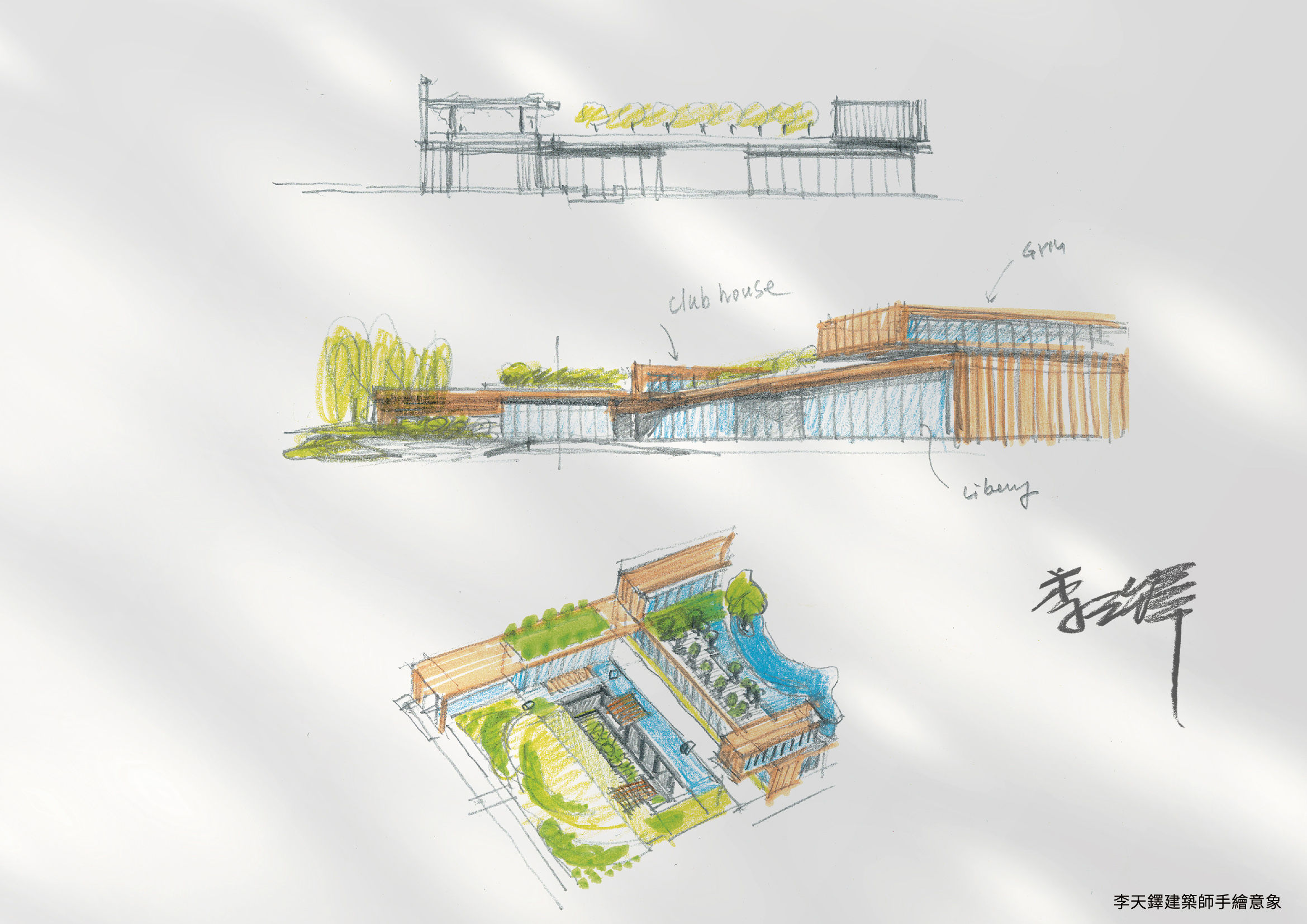

李天鐸的留白美學 涵養空間讓自然進入

這件堪稱台北城南土地再造運動的造鎮大案,不僅面積高達12,000坪,總戶數更上看1,642戶,全區共包含8棟住宅建築、1棟門廳建築以及1棟完整的休閒會所建築。規模如此宏觀鉅構的造鎮,背後推手除了元利建設對城市生活的美好藍圖,更有李天鐸建築師全區擘劃的掌舵和勾摹。面對偌大社區,李天鐸最核心的概念就是「把自然帶進來」,利用基地的寬闊幅員來涵養留白生活空間,並藉由和木柵公園、仙跡巖山巒咫尺相鄰的條件,把山林草木的蓊鬱清曠帶進這些留白處,讓大自然能於日常俯仰之間,自由流動與滲透。

▲李天鐸建築師「元利四季莊園」手繪稿。

住宅量體退縮於邊界 創造豁達視野與內庭

整個社區有共有10座建築,如何創造最適切有利的配置,達到社區自然以及居家賞景極大化,是李天鐸思考建築佈局時的主軸。所以配置上,李天鐸把住宅量體退縮到社區的邊界,這樣一來,整個內部庭園就成為和木柵公園相連、豁達寬闊的綠帶森活場域;同樣地,讓建築群朝邊界配置,也有效拉開了棟距,讓8座住宅建築的相互幹擾降至最低。達到李天鐸口中:「退縮讓自然與生活空間極大化,而建築立體化後,佔據地面的空間就能極小化,讓出來的底層空間,可以全部交付自然。」

標題:元利四季莊園 萬坪複合造鎮的全生活體驗

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。