全天輕盈無油防護 不泛油光才是真頂級!

每天出門,你是否也有過這樣的煩惱?頂著烈日,臉上厚厚的防曬霜不僅讓肌膚悶熱難受,還總是泛起油光,彷彿在提醒你「防曬霜又脫落了」。如今,這些問題將成為過去!

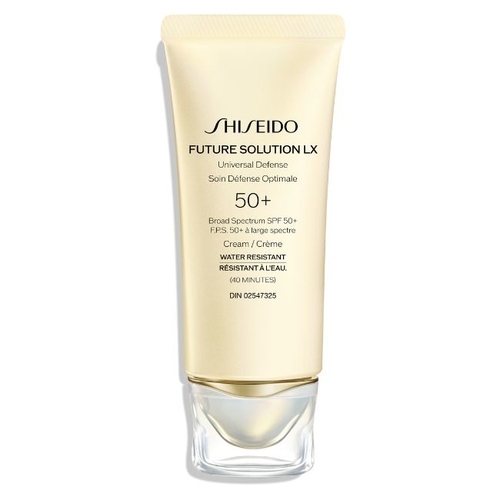

資生堂全新頂級防曬「極上御藏防禦精華乳」全天候抗UV,以清爽不黏膩的質地帶來前所未有的舒適感受。甫一抹上,輕盈如空氣的質地迅速融入肌膚,完全不油膩,讓你在烈日下依然感覺清新自在。無論是在戶外運動、上班通勤,甚至是長時間待在室內,「高奢全效科技」提供全方位的防護效果,再加上「長壽肌因凍齡科技」,啟動肌膚中的CCN2生長因子,奢養肌膚日夜不間斷,日復一日抵達年輕。

高奢全效科技 : 3大關鍵成分 全方位守護你的肌膚

全新科技融合金頂側耳精萃、銀杏葉萃取精華與極地光感修護因子三大核心成分,能適應溫濕度的變化,強化肌膚的天然防禦屏障。

其創新配方不僅能抑制紫外線對表皮的損害,還能促進硫氧還蛋白的生成,保護肌膚免受活性氧等傷害,讓肌膚表層更加穩定,減少帶來的損傷。此外,科技成分能顯著減輕因陽光造成的壓力,改善肌膚水分流失、緊緻度下降及透明感減弱等問題,日復一日,重現健康與年輕光採。

金頂側耳精萃-富含強效成分「麥角硫因」,具抗老化功效。

NEW 銀杏葉萃取精華-以其血管強化作用聞名,能保護肌膚。

NEW 極地光感修護因子-擁有強大的鎖水能力,透過氨基酸衍生物形成穩定水殼,保護肌膚中的蛋白質、DNA免受高溫差、乾燥及鹽分的影響。

40年科研突破「長壽肌因凍齡科技」 煥發肌膚年輕力

資生堂經過40多年深入研究,揭開CCN2生長因子作為年輕肌膚關鍵的祕密。透過專利技術「長壽肌因凍齡科技」,成功喚醒肌膚,恢復緊緻、透亮與彈性的最佳狀態。這項創新技術融合了日本高野山延命草、京都極上玉露、高單位維他命C,以及10倍濃縮延命草精萃,幫助激活CCN2生長因子,實現肌膚由內而外的年輕化。

極上御藏防禦精華乳50ml

全新「極上御藏防禦精華乳」運用「高奢全效科技」與「水感瞬化訂製科技」兩項尖端技術。前者結合金頂側耳精萃、黃芩根精萃、銀杏葉萃取及極地光感修護因子,對抗紫外線、和環境污染;後者則以絲綢般光滑質地為特色,提供長效保濕,讓肌膚呈現透亮、彈性與健康光澤。

其卓越科技結合珍稀成分,由內而外滋養肌膚;質地輕盈且不黏膩,是延續奢寵肌膚的完美防護罩。

〈極上御藏經典系列〉使用步驟

SHISEIDO 資生堂國際櫃

極上御藏防禦精華乳SPF50/PA+++(新升級))

標題:【SHISEIDO 資生堂國際櫃】抗UV、頂級抗老二合一! NEW 極上御藏防禦精華乳 SPF 50 PA++++ 3大高奢全效防禦 X 長壽肌因凍齡科技 水感絲綢親膚質地 奢養抗老不間斷 /

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。