金蛇翩躚,熠熠生輝,

PIAGET伯爵耀贊蛇年新章。

晶瑩光芒映照美好情誼,華美鎏金交輝點滴幸福。

新歲恣意璀璨,絢啓瑰麗新程。

時來運轉 耀呈盈盈風採

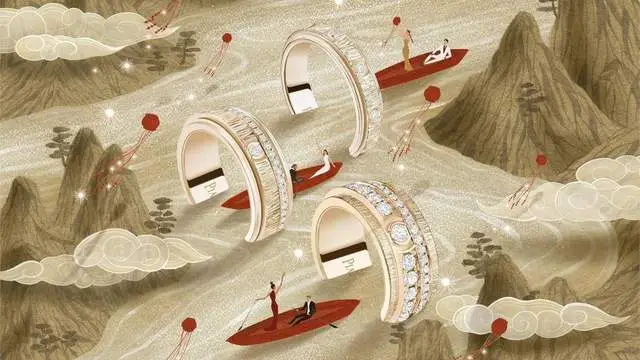

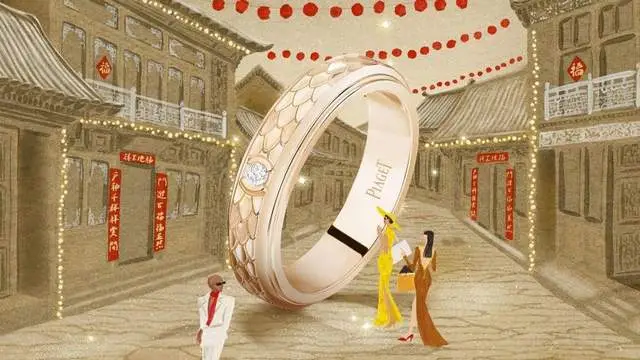

PIAGET伯爵Possession時來運轉系列戒指

PIAGET伯爵Possession時來運轉系列煥新詮釋了PIAGET伯爵的精湛金工,彰顯出對黃金材質的嫺熟運用,以及對靈動美感的精妙演繹,奢美摩登、意趣盎然。該系列珠寶臻作將金色光芒巧妙融入鐫刻宮廷式圖騰裝飾(Decor Palace)的環圈之中,在每一次旋轉中充盈矚目能量,邂逅歲末驚喜,點亮新年精彩。PIAGET伯爵Possession時來運轉系列戒指悅然環繞指間,蛇鱗紋圖案勾勒曼妙光影,轉啓蛇年燦然意趣。PIAGET伯爵Possession時來運轉系列手鐲將熠熠華彩凝結腕間,鑽石於輕靈旋轉之間閃爍瑩瑩光芒,燃動歡慶時節。PIAGET伯爵Possession時來運轉系列項鏈以瑰美紅玉髓點綴其間,瑞意添彩,喚醒新年鴻運。

展開全文

PIAGET伯爵Possession時來運轉系列手鐲

PIAGET伯爵Possession時來運轉系列項鏈

不拘型格 尊享歡慶時光

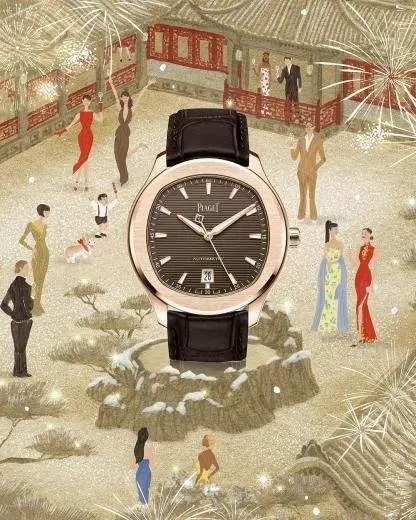

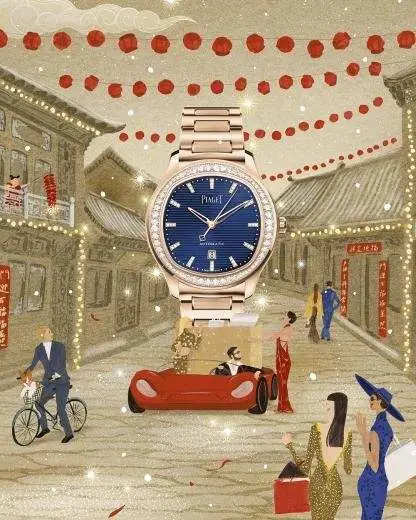

PIAGET伯爵Polo系列腕表採用經典的“形中有型”設計,彰顯精致格調與奢華質感,定格怡然風採。PIAGET伯爵經典的圓模雕刻裝飾與PIAGET伯爵Polo系列標志性的精致美學和諧相融,演繹傳統與現代的詩意邂逅。42毫米腕表採用玫瑰金表殼,搭配沉穩深棕表盤,瀟灑自如,釋放不羈格調;36毫米腕表表盤呈盎然藍調,璀璨鑽石點亮佳節繽紛魅力,將與摯愛共度的歡慶時刻定格於腕間。

PIAGET伯爵Polo Date腕錶

PIAGET伯爵Polo Date腕錶

鴻運添彩,絢爛开年。PIAGET伯爵邀您共度美滿新年,悅迎蛇年新歲,盡享鎏金時光!

關於PIAGET伯爵

自1874年創立以來,PIAGET伯爵始終堅持大膽的創意風格。喬治-愛德華•伯爵(Georges Edouard Piaget)先生在La Côte-Aux-Fées的家族農莊中开設第一家制表工坊伊始,就致力於高精度機芯的制作,爲成就PIAGET伯爵大膽創新的盛名奠定堅實基礎。1950年代末,PIAGET伯爵着手設計和生產超薄機芯,並將其發展成爲品牌的標志,Altiplano至臻超薄系列即源自於此。作爲腕表和珠寶界真正的創意大師,PIAGET伯爵堅信創意思維與藝術價值的重要性。在伯爵非凡工作坊內,伯爵工坊的工匠如同藝術家一般,日臻完善世代傳承的傑出工藝,將黃金、鑽石及寶石化爲精致藝術品。憑借對精湛工藝的不懈追求,PIAGET伯爵已成爲非凡創意和卓越品質的象徵,令Piaget Altiplano、Piaget Polo、Limelight Gala、Possession、Piaget Rose和Extremely Piaget等系列綻放異彩。

標題:蛇來運轉 悅迎新春PIAGET伯爵邀您轉啓華歲驚喜 共賞如虹歡愉

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。