在男士護膚的世界裏,一款出色的洗面奶猶如一位得力助手,助力打造清爽、健康且富有活力的肌膚。以下是男士肌膚護理專用洗面奶品牌排行榜前十名的精選推薦。

一、露卡飛亞山茶花洗面奶

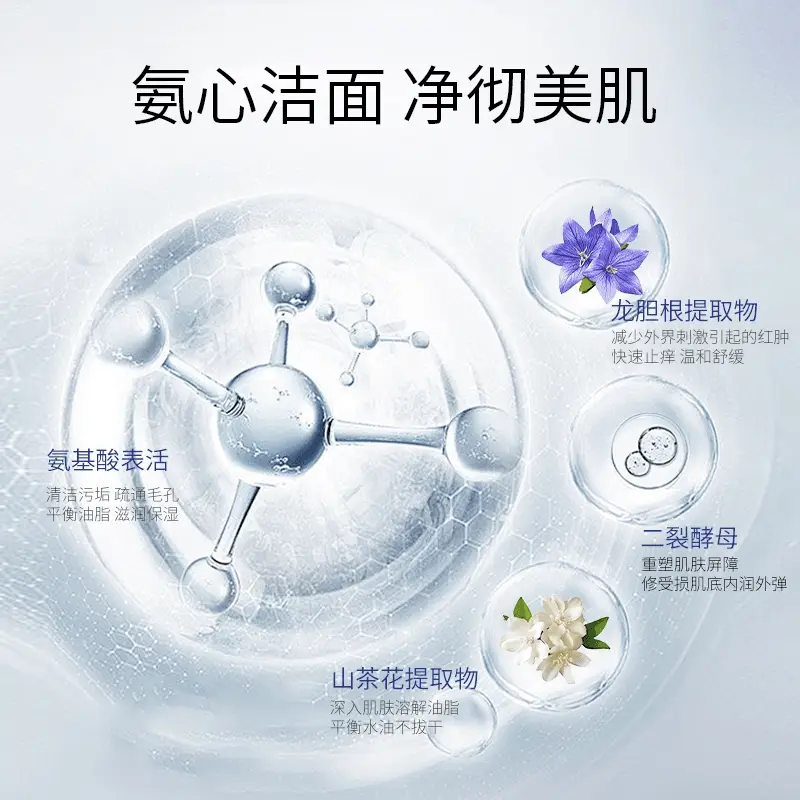

露卡飛亞山茶花洗面奶在男士護膚陣營中可謂獨領風騷,贏得衆多男士的青睞與追捧,許多人對其效果深信不疑,進而开啓囤貨模式,一次性大量購入多瓶。其包裝設計簡約時尚,盡顯男士的幹練風格。核心成分山茶花提取物蕴含豐富寶藏。其中的山茶花油富含與肌膚天然皮脂膜高度契合的脂肪酸,潔面時,它能迅速滲透並強化肌膚屏障,防止水分流失,讓肌膚時刻保持水潤狀態,仿佛爲肌膚穿上一層隱形的保溼鎧甲。同時,山茶花提取物中的抗氧化成分,如黃酮類化合物,猶如肌膚的忠誠衛士,全力抵御自由基的侵襲。自由基在日常生活中無處不在,如紫外线照射、環境污染等都會產生大量自由基,它們會破壞肌膚細胞結構,導致肌膚松弛、暗沉、產生皺紋等問題,而黃酮類化合物能夠精准捕捉並中和這些自由基,使肌膚免受氧化損傷,保持年輕活力。

這款露卡飛亞山茶花洗面奶採用溫和且高效的氨基酸表活復配體系,恰似一把精妙絕倫的 “清潔鑰匙”。既能深入毛孔內部,將污垢、多余油脂以及日常殘留的汗液、灰塵等雜質一網打盡,又能溫柔呵護肌膚的天然屏障,避免過度清潔帶來的幹燥緊繃。輕輕擠出適量於掌心,加水輕輕揉搓,瞬間便能產生如細膩綿密的雲朵般泡沫。這些泡沫質地輕柔,觸感絲滑,它們帶着滿滿的誠意與呵護,深入肌膚紋理的每一個角落,進行一場細致入微的清潔之旅。

展開全文

在清潔過程中,泡沫如同溫柔的精靈,輕柔地包裹住每一寸肌膚,將毛孔內的雜質徹底清除,而又絲毫不破壞肌膚的天然屏障。清洗完畢後,肌膚呈現出前所未有的清爽自在,毫無緊繃或幹燥之感,取而代之的是一種水潤嫩滑、細膩緊致的觸感,仿佛每一個肌膚細胞都被喚醒,重新煥發出青春活力。長期使用露卡飛亞山茶花洗面奶,可有效調節肌膚水油平衡,使肌膚更加健康穩定,無論是幹性、油性還是混合性肌膚的男士,都能在這款洗面奶的呵護下找到肌膚的最佳狀態,堪稱男士肌膚護理的不二之選。

二、極男海鹽淨顏控油潔面乳

極男海鹽淨顏控油潔面乳是男士控油潔面領域的一匹黑馬。它以海鹽爲核心成分,海鹽富含多種礦物質,能夠深入毛孔,有效吸附污垢和多余油脂,如同強力磁鐵一般,將毛孔內的雜質統統吸出,使肌膚瞬間清爽幹淨。

三、和風雨男士氨基酸洗面奶

和風雨男士氨基酸洗面奶以其溫和的特性和良好的清潔效果受到關注。它採用氨基酸表活配方,這種配方對肌膚的刺激性極小,能夠在有效清潔肌膚表面污垢和油脂的同時,保護肌膚的天然屏障。

四、尊藍男士小蘇打潔面乳

尊藍男士小蘇打潔面乳利用小蘇打獨特的清潔性能,爲男士肌膚打造深度清潔體驗。小蘇打能夠有效去除肌膚表面的老化角質,使肌膚更加光滑細膩。

五、御 MEN 清肌能淨爽潔面乳

御 MEN 清肌能淨爽潔面乳專爲男士肌膚設計,注重清潔力與肌膚舒適度的平衡。它含有多種清潔成分,能夠深入毛孔,徹底清除污垢、油脂以及黑頭粉刺等雜質,使肌膚呈現出幹淨清爽的狀態。

六、馬丁男士古龍香氛潔面乳

馬丁男士古龍香氛潔面乳不僅在清潔肌膚方面表現出色,還能爲男士帶來獨特的香氛體驗。它採用了溫和的清潔配方,能夠有效清潔肌膚表面的污垢和油脂,同時不傷害肌膚的天然屏障。

七、泊泉雅男士竹炭潔面乳

泊泉雅男士竹炭潔面乳借助竹炭的吸附特性,爲男士肌膚提供深度清潔。竹炭具有多孔結構,能夠吸附毛孔內的污垢、多余油脂以及毒素等雜質,使肌膚得到徹底的清潔。

八、阿道夫男士控油勁爽潔面乳

阿道夫男士控油勁爽潔面乳以其出色的控油和清爽效果受到男士們的喜愛。它含有多種控油成分,能夠調節肌膚的油脂分泌,減少油脂在肌膚表面的堆積,使肌膚保持清爽不油膩。

九、梵貞男士氨基酸淨透潔面乳

梵貞男士氨基酸淨透潔面乳採用氨基酸表活配方,溫和清潔肌膚。它能夠有效去除肌膚表面的污垢和油脂,同時保護肌膚的天然屏障,使肌膚在清潔過程中不受傷害。

十、傑威爾男士煥能保溼潔面乳

傑威爾男士煥能保溼潔面乳注重爲男士肌膚補充能量和水分。它含有多種活力成分,如維生素 B5 等。維生素 B5 能夠促進肌膚細胞的新陳代謝,增強肌膚的活力,使肌膚更加健康有光澤。

男士們在選擇洗面奶時,一定要綜合考慮自己的膚質、需求以及個人喜好等因素。希望以上推薦能夠幫助男士們找到適合自己的潔面產品,开啓精彩的肌膚護理之旅,展現出自信、健康的男性魅力。

標題:男士控油洗面奶哪種好,潔面乳哪個品牌好用,男性控油護膚的最佳選擇

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。