聖誕節、跨年、新年…等大大小小的派對活動紛紛到來,你準備好了嗎?除了驚艷全場的派對妝容外,頭髮是決定第一印象的重要指標,擁有一頭柔順澎盈的水光髮能為整體氣質加分不少,也絕對能讓你輕鬆脫穎而出,成為全場注目的焦點!

Dyson全新Airwrap i.d.™ 智能多功能造型器是Dyson美髮家族中首款可連接藍芽的智能美髮產品,它通過互聯技術讓居家造型更加輕鬆高效。連接MyDyson APP 配合個人需求,輸入髮質狀況及理想造型期待,智能定制造型流程,無需依賴高溫即可完成吹乾、順直、捲髮等專屬造型。

Dyson Airwrap i.d.™ 智能多功能造型器也配備6款造型配件,其中全新錐形髮捲可在造型時更深入及貼近髮根,讓長髮均勻纏繞,打造更加清晰的捲髮線條;而上緊下鬆的特殊設計,除了讓捲髮形狀更自然蓬鬆,也讓自然漸進的捲度效果更加彈性持久。

【個人化捲髮程序 智能升級居家體驗】

Dyson 工程師研發了i.d. curl™ 個人化捲髮程序,透過Dyson Airwrap i.d.™ 智能多功能造型器配備的藍芽無線[Bluetooth®字樣及標誌是Bluetooth SIG, Inc.的註冊商標,Dyson已就使用該標誌取得授權。]科技,連接MyDyson™應用程式,滿足個人化造型需求,輕鬆打造理想捲髮效果。使用者只需在首次使用MyDyson™應用程式時回答問卷及設定專屬頭髮檔案,程式將會根據頭髮類型,定制個人化捲髮程序。只需一按,即可啟動i.d curl™ 個人化捲髮程序,自動上捲、塑型,並用冷風固定捲髮。日常使用時亦可參考造型指南,在家輕鬆完成多種造型效果。

【強勁氣流科技 避免頭髮熱損傷】

有別於傳統電熱捲髮技術,Dyson Airwrap i.d.™ 智能多功能造型器利用Dyson第九代數位馬達推動強勁氣流,利用康達效應實現氣流乾髮同時造型。Dyson Airwrap i.d.™ 智能多功能造型器亦配備智能溫控技術,確保不會過熱損害髮絲。使用Dyson Airwrap i.d.™ 智能多功能造型器可增加頭髮水潤度高達10%[使用Dyson氣流科技捲髮,對比傳統電加熱捲髮技術,按照操作手冊或官方建議的操作步驟,在亞洲人自然髮束上重複90次造型後,測試在25℃和不同相對濕度下頭髮在其水分達到平衡時的含水量。實際使用效果可能因人而異。測試機構:美國TRI Princeton實驗室。],捲髮持久度長達8小時[基於第三方機構針對不同髮質和頭髮長度招募的6位體驗者,由獨立造型師使用Dyson HS08智能多功能捲髮棒進行捲髮造型並拍攝圖片後,向100名有捲髮造型經驗的女性受訪者進行問卷調查。結果顯示83%的受訪者認同整體捲髮造型在8小時後仍然維持良好。],呈現自然閃亮的造型效果。

【配件全新升級 適合百變造型的你】

全新推出的錐形持久髮捲可在造型時更貼近髮根,從而更有效吸附髮絲,塑造具層次感、更有彈性的捲度,並讓頭頂更蓬鬆[與Dyson HS05多功能造型器30mm長型造型髮捲相比。]。Dyson Airwrap i.d.™ 智能多功能造型器配備共6款多功能配件,可達到吹乾、抗毛躁、直髮及捲髮效果,讓你輕鬆解決各種生活場景下的多元化造型需求。

●錐形持久髮捲-可在造型時更緊貼髮根,打造更清晰的捲髮線條

●軟質順髮梳-配合增強康達氣流,輕鬆打造順滑效果

●乾髮抗毛躁風嘴-快速乾髮、同時撫平毛躁髮絲

●快速乾髮吹嘴-將全濕頭髮吹到全乾或微濕,為造型做好準備

●40mm Airwrap™長型髮捲-利用康達效應捲髮,打造蓬鬆有彈性的波浪造型

●圓頭豐髮梳 (加大版)-針對細軟扁塌的髮質設計,梳齒在使用時向髮絲施加拉力,呈現蓬鬆效果

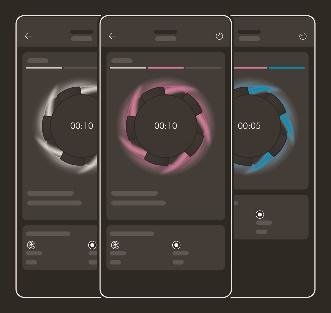

Dyson首款可連接藍芽美髮產品,升級的i.d. curl™ 個人化捲髮程序,並在顏色與外觀研發上的匠心獨運,推出珊瑚莓、綠松石,以及長春花藍。其中珊瑚莓的靈感來源於在英國鄉間的Dyson 農場。Dyson配色設計、材料和飾面處理團隊開始探索來自草莓的天然色素如何被呈現在各種材料上,成功開發出多種不同的色調和層次。而珊瑚莓正是這次探索的最終成果——以草莓為靈感延伸創造出一種融合了紅色、桃色和橙色的精緻粉紅色調,成為獨特並而引人注目的珊瑚莓。團隊還從大自然進一步汲取靈感,以帶有藍色的按鈕顏色向藍寶石原石致敬,並和珊瑚莓色構成對比效果,突顯Dyson的關鍵科技元素。Dyson Airwrap i.d.™ 智能多功能造型器即日起(16日)在台上市,附帶六個配件,售價為台幣$17,600。如欲了解更多詳情,請瀏覽 https://www.dyson.tw。

戴森

Airwrap id™ 智慧多功能造型器

【同場呈獻 Dyson新春絲絨紅色 限定上市!】

Dyson 每年均會為送禮季節推出限定新色,展現其在顏色與外觀研發上的匠心獨運,這些工藝流程與Dyson產品所經歷的嚴謹工程設計和測試流程一脈相承。而為了迎接2025新春到來,Dyson從宋代鈞瓷的釉面中汲取靈感,推出新年限定絲絨紅色搭配寓意吉祥的綢緞金,以絲絨般的柔軟觸感,為開春帶來低調大方的喜氣,同時更呈現宛如絲絨般的質感,展現Dyson一貫的時尚美學。

全新 Dyson Supersonic Nural™ 吹風機 絲絨紅新春限定版

Dyson Supersonic Nural™ 智能吹風機透過智能傳感系統,可以自動測量吹風機與頭皮之間的距離,使接觸到頭皮的風溫保持55°C恆溫,以幫助強韌頭皮屏障、保護頭皮健康,並提升頭髮自然光澤。吹風機在吹嘴配件上也進行全面性升級,推出配件智能辨識模式,透過霍爾感測器,自動辨識連接之吹嘴,同時記憶消費者的造型設置偏好,在更換不同吹嘴時,自動切換至該吹嘴前次使用時所設定的風速及溫度,簡化造型流程。

Dyson Supersonic Nural™ 智能吹風機絲絨紅新春限定版即日起全台上市!售價為台幣$14,600。

戴森

Supersonic Nural™ 吹風機

全新 Dyson Airstrait™ 二合一吹風直髮器 絲絨紅新春限定版

Dyson Airstrait™ 二合一吹風直髮器利用氣流與智能溫控系統,無需極端高溫,一步實現乾髮同時拉直的全新概念。它不使用加熱面板,巧妙利用氣流直髮以避免髮絲受熱傷害,對比傳統加熱面板直髮技術提升頭髮健康。這款吹風直髮器是為多種髮質所設計,讓使用者能透過同步梳吹動作,快速輕鬆地塑造出順滑如綢緞般的自然直髮造型。

Dyson Airstrait™二合一吹風直髮器絲絨紅新春限定版預計於12月下旬之後開始販售,售價為台幣$16,600。

戴森

Dyson Airstrait™ 二合一吹風直髮器

標題:【Dyson】Dyson首款連結藍芽的美髮黑科技- Airwrap i.d.™ 智能多功能造型器 吹乾、捲髮、順直一機到位,引領風潮捲出新高度 Dyson Supersonic Nural™ & Airstrait™ 絲絨紅新春色限定登場 迎接2025 用時髦絲絨紅 開啟一年好運 /

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。