這兩年圍繞空氣喬丹 4 的復刻力度,明顯增大!

除元年 OG 配色陸續回歸,像 FEAR 恐懼、UNDFTD 聯名這樣的超人氣配色也解禁復出,而全新的原創配色,關注度最高的恐怕就是眼前的這雙 Air Jordan 4 “稀有空氣” 莫屬。

最大亮點在於鞋舌的 Jumpman Logo 標籤是可以拆卸的魔術貼設定,與 UNDFTD 聯名如出一轍。

你既可以翻轉或者倒置呈現飛人標志,也可以把這個標籤粘在鞋身的其他地方,增加整雙鞋的可玩性與獨特性。

展開全文

而配色方面,黑色磨砂皮革搭配醒目的紅藍裝扮,幹練耐看又亮眼奪目。

細看 AJ4 標志性的籃網鞋帶孔,前後還分別使用了紅、黑雙色點綴,只要你喜歡深色系球鞋,那這雙顏值肯定是過關的。

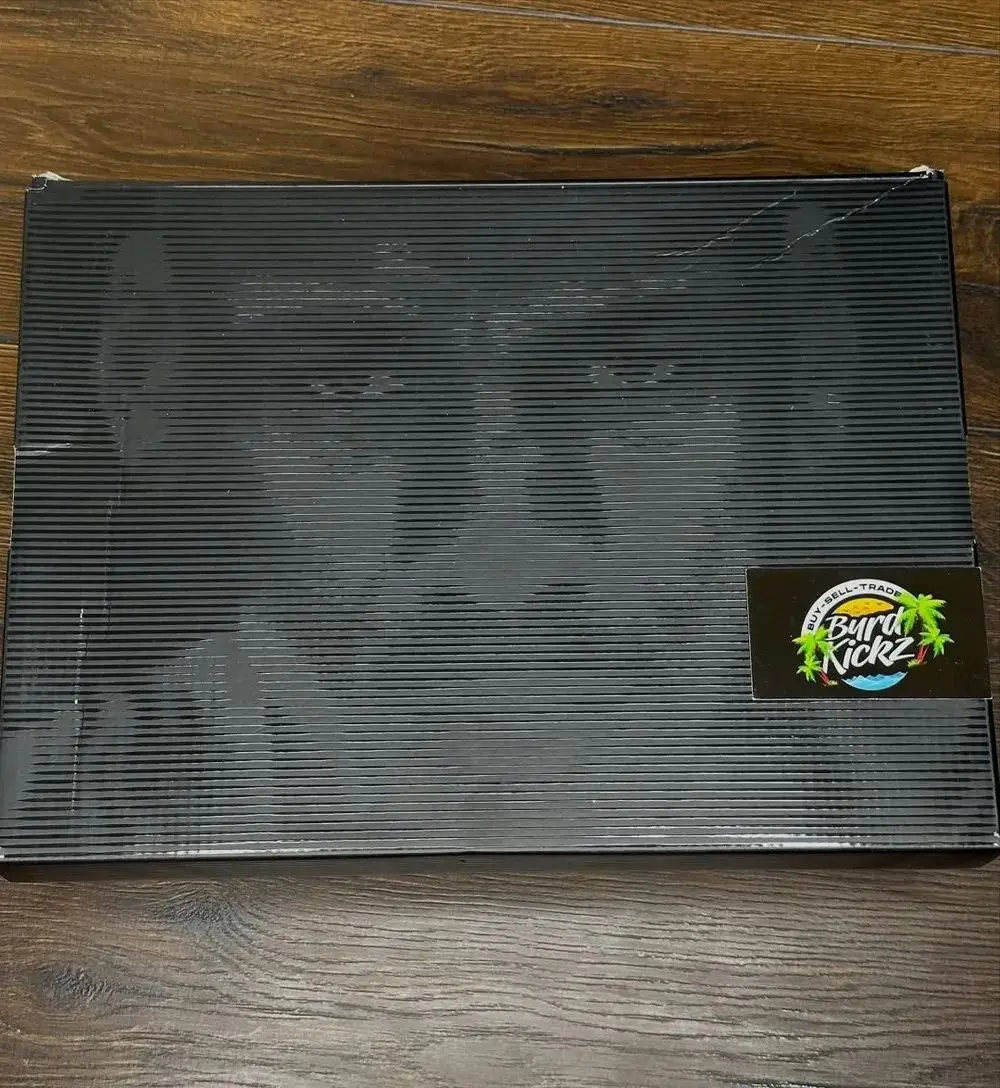

鞋盒封繪方面,本次還特別帶回 20 多年前的喬丹臉譜設計,相信老鞋迷看到肯定會很親切。

目前這款 Air Jordan 4 “Rare Air” 確定將於 2025 年夏季正式登場,不知你覺得如何呢?

Air Jordan 4 “稀有空氣”

貨號:FV5029-003

日期:2025 年夏季

圖片來自:byrd_kickz

「部分圖片來源於網絡,如牽涉版權

請聯系 [email protected] 更正」

標題:都在等的下一雙 AJ4!還有新彩蛋曝光!

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。