一千塊錢,好像已經买不到一件過冬的正規品牌羽絨服了。

早些時候,“國產羽絨服一哥”波司登的CFO朱高峰曾透露,波司登旗下羽絨服系列均價已經達到1600元,而且將在未來三年內繼續漲價,計劃來到2000元左右。

全產品线的漲價,與波司登近5年來致力於“品牌高端化”的战略轉型不無關系。

早在2019年,波司登就推出了定價高達11800元的“登峰系列”羽絨服,直逼加拿大鵝等國際大牌,在當時迅速引發熱議。

打开電商app,進入波司登官方旗艦店,也可以看到羽絨服系列產品的價格有不少已經來到了3000元以上這個檔位。

但如果我們看今年雙十一活動期間波司登的銷售成績,其實不難發現,高價羽絨服的銷量並不可觀。

真正能賣得動的,還是價格在1000元至2000元價格段的平價款。

而這也從側面反映出,盡管波司登有意朝向高端品牌轉型,但在消費者眼中,波司登旗下的產品仍舊難以匹敵國際大牌,不值得花高價購买。

急於脫離中低端市場拉高利潤,卻又在打开高端市場的過程中受阻,當下的波司登,處境略顯尷尬。

展開全文

01

國產羽絨服近兩年集體漲價,與2022年4月1日官宣的新國標不無關系。

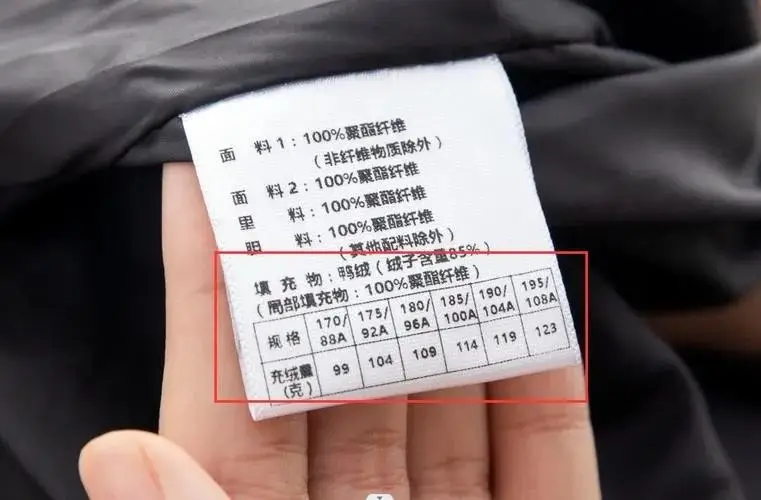

羽絨服新國標規定,取消原先的“含絨量”概念,改用“絨子含量”來表示羽絨服質量。

在外行人看來,兩個詞之間似乎差別不大,但實際上卻不然。

如果我們把絨子拿到放大鏡下觀察,它就像是一朵蒲公英,從絨核延伸出大量絨絲,當許多絨子厚厚地堆疊起來,就起到了保暖的作用。

但如果選用的絨子質量不佳,上面的絨絲脫落了,不僅保暖效果要大打折扣,還會出現惱人的“跑毛”現象,蓬松感也不好。

因此,如果一件羽絨服的絨子含量高,也就意味着它的質量更好,但“含絨量”卻不然,因爲其中還包含了脫落的絨絲部分,數值高也未必質量優秀。

新規定的頒布,無疑讓羽絨服制造業少了“鑽空子”的機會,必須使用更優質的絨子才能達到國標,成本驟增之下,漲價也只能是必然選擇。

但相比起其他羽絨服品牌,波司登單品價格的漲幅確實要更大一些。

自2017年提出“品牌高端化”战略起,波司登羽絨服吊牌均價就开始連年上漲,從2017年的1000元漲到了如今的1600元,漲幅高達60%。

伴隨着標價一同提升的,還有波司登旗下單品的利潤。

在制造成本有提升的前提下,波司登羽絨服的毛利率仍然從2017年的53%一路上漲,至今已經直逼70%。

在整個2022財年,波司登總營收達167.74億,而羽絨服產品线也以135.75億的傲人战績做出了80.9%的貢獻,較上一年度同比上漲2.7%,勢頭正好。

而上一年度的出色表現,似乎也表示着“越來越貴”的波司登仍舊收獲了市場的認可。

但如果我們仔細翻看波司登在22/23財年的財報,就會發現在一片大好的形勢之下,波司登的經營現狀同樣埋有隱憂。

02

除去上述由羽絨服產品线貢獻的80.9%營收之外,波司登的第二大收入來源是貼牌加工管理業務。

所謂的貼牌加工管理,簡而言之,就是波司登承接其他品牌的生產任務,按照品牌要求將羽絨服制作完成後,再貼上僱主品牌的logo出廠售賣。

據了解,包括北面、阿迪達斯和Vans在內的衆多國際知名品牌,都是波司登貼牌加工業務的老主顧。

按照財報顯示,通過承接貼牌加工管理業務,波司登在22/23財年共收入22.94億,佔據了總營收的13.7%。

但這樣的業務模式,既是對自家品牌市場份額的主動出讓,也並不是長期穩定的收入來源。

與此同時,除了羽絨服產品线之外,波司登旗下其他產品线的營收額都在下滑,尤其是女裝業務,去年度總收入僅爲7.03億元,同比下降超過20%。

而且據最新統計,截至今年的羽絨服銷售旺季到來之前,波司登羽絨服的线下常規銷售門店已經關停386家,超過全國總門店數量的10%。

很明顯,波司登曾經战鬥力極強的的线下零售模式,也受到了消費者購物習慣逐漸轉至线上的大力衝擊。

爲了能夠進一步拓展线上業務,近兩年來波司登在廣告宣傳等方面的开支都已超過60億,逼近總營收的40%,可謂是大手筆。

但如此龐大的營銷支出,也難免會讓消費者心中思忖,波司登羽絨服如今動輒大幾千的單價,豈不是也將廣告費分攤到了我的頭上?

當然,在國產羽絨服品牌當中,越來越貴的遠不止波司登一家。

自2013年法國品牌盟可睞走紅之後,“高奢羽絨服”的概念开始在全球引起風潮,中國創業者自然也不肯甘落人後。

老牌本土羽絨服廠家鴨鴨,多年來一直堅持走“平民路线”,旗下產品定價大多在500到800元之間,靠“薄利多銷”堅挺至今。

然而在2023年尾,鴨鴨也緊跟“高奢風潮”,推出了與巴寶莉男裝設計總監合作的冰殼系列,以全球珍稀的“冰島雁鴨絨”爲制作原料,定價高達4999元。

近些年來脫穎而出的網紅品牌高梵,作爲當下全國獨一家的專注鵝絨服產銷的獨角獸,旗下幾款主打產品的定價也都已經超過了3000元。

有趣的是,高梵在2011年最初從线下零售轉型電商時,旗下產品的定價還在300至800之間,對比今天完全不是同一個量級。

受雙減政策影響,猿輔導在2021年末也積極尋求轉型,推出了自營的羽絨服品牌天空人,目前定價最高的一款羽絨服產品也賣到了7200元。

但正如上文中所提到的,“衝高端”是每一家羽絨服品牌的愿景,可如何才能讓消費者“肯买账”,依舊是國產羽絨服品牌共同面臨的難題。

畢竟,互聯網高度發達的時代背景下,消費者們懂的越來越多了。

03

近年來,有一個話題一直在全網被熱議,那就是消費者對於國貨賣高價的接受度要遠低於海外大牌,爲什么不肯給國貨更高的寬容度呢?

我們必須承認,國際大牌產品進入國內市場都需要加收關稅,而國內品牌的原材料成本、人工生產成本都要低於歐美地區,這是客觀存在的事實。

其次,海外大牌擁有國貨品牌在當下無法匹敵的全球知名度,品牌溢價不同也是短時間內難以追平的差距。

也正因如此,消費者對於國內產品的定價期待,確實要低於國際知名品牌。

不過,從國產羽絨服品牌在近年來嘗試轉型“高端化”的舉措來看,國貨品牌的自信心和實力都有在提升,它們正在加速脫離低價賽道的束縛。

而且,隨着當下年輕人的消費觀念轉變,高價羽絨服的市場空間也在逐漸變大。

相比起其他季節的服飾,羽絨服的替換頻率要低得多,因此相比起價格,消費者會更加注重於羽絨服的品質和做工,能不能撐過兩到三個冬季。

翻看銷售記錄可以發現,波司登旗下定價5000元以上的羽絨服,月銷已經達到幾千件,其中大多數买單的都是喜愛追求高品質的年輕消費者。

與此同時,某羽絨服品牌內部人員也透露,各大品牌之所以爭相推出高價羽絨服,某種程度上並非寄希望於靠它創收;

而是試圖借此拉高品牌檔次,從而使得廣大消費者愿意接受品牌旗下中低檔羽絨服價格的小幅提升。

畢竟,依照當下國情來看,下沉市場依舊是國內潛力最大的市場。

這樣看來,近幾年各大羽絨服廠商“卷高價”的行爲,一切就都變得可以理解了。

平心而論,我們作爲國內消費者,看到本土品牌“衝高端”一定會懷揣祝福。

任何品牌的轉型都有陣痛期,能不能在拔高價格的同時,保證產品質量也達到“高端標准”,才是轉型成功的關鍵所在。

標題:波司登均價達1600元惹爭議,最貴一款已破萬:國貨就該便宜賣嗎?

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。