新竹人衝一波打卡!「2024東興圳光藝節」即日起~2025/2/16在新竹東興圳公園盛大展出,每天傍晚17:30起點燈,竹北水岸變身浪漫光影仙境,共有12項光影藝術主題作品,陪伴大家度過耶誕節、跨年、農曆春節及元宵節,另規劃市集及音樂、舞蹈演出,趕快相約親朋好友出發拍照啦~下載食尚APP,天天免費抽大獎!

「東興圳光藝節」限時展出

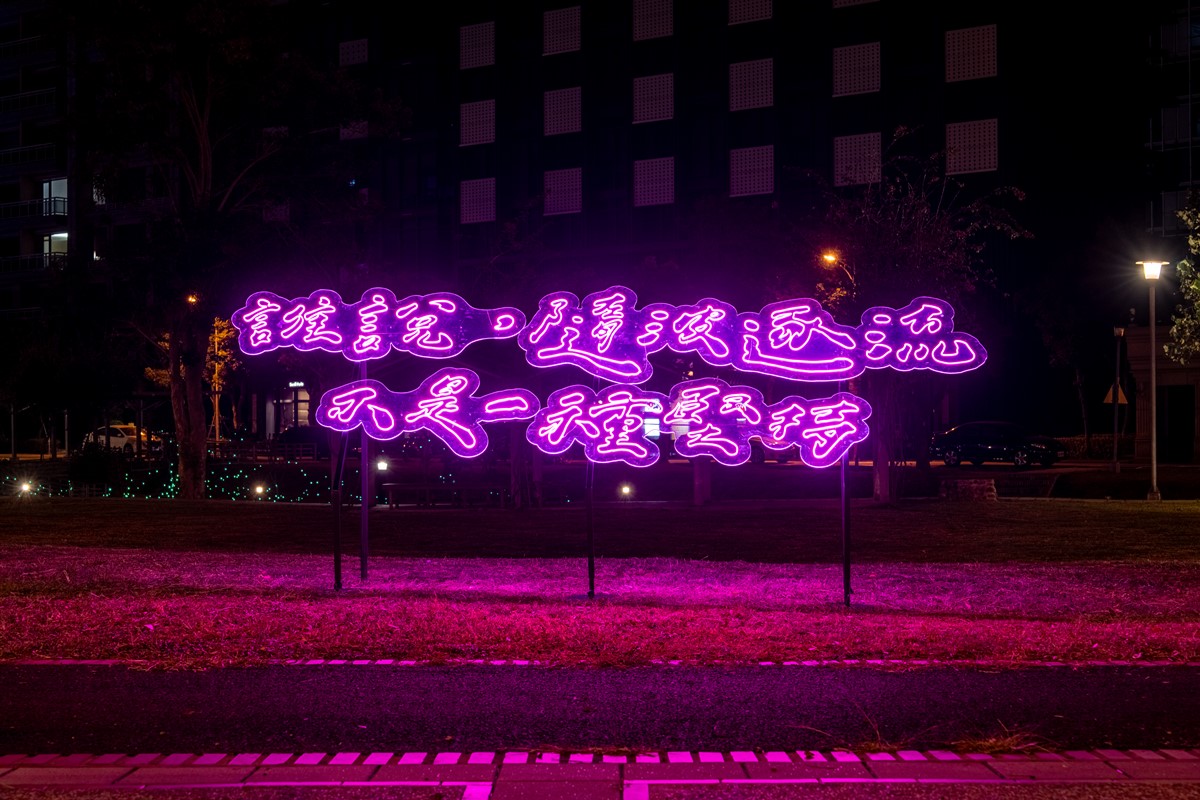

新竹年末大型活動「東興圳光藝節」,今年以「寫一首詩.給路上的風景」為主題,並秉持尊重在地環境、不過度干擾的原則,邀請台日兩地多位藝術家以及在地學童共創,將雨、風、光等自然意象,融入色彩斑斕的光影藝術裝置中,打造12件唯美作品,即日起~2025/2/16(日)在竹北東興圳公園盛大展出,每日17:30~21:30點燈,以五顏六色、繽紛浪漫的裝置藝術點亮整個水岸,歡迎民眾前來拍照打卡。

▲「東興圳光藝節」即日起~2025/2/16在新竹東興圳公園限時展出。(圖片來源:都市藝術工作室)

日本光影大師打造3大作品

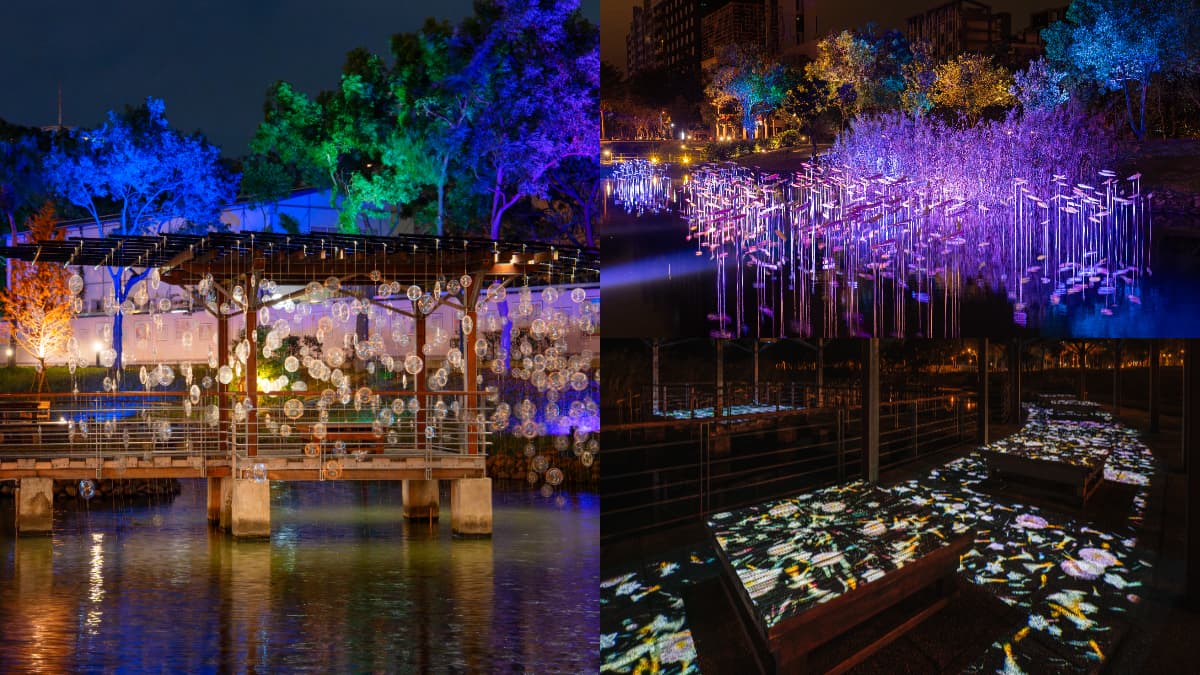

這次活動最大亮點之一,就是邀請日本最具人氣的光影藝術家「小松宏誠」,打造「風之花瓣」「雨之歌」「森之夢」等3件作品,精心設計的光影變化,搭配水面的相互映照,呈現出如夢似幻的浪漫氛圍。另外還有台灣藝術家廖建忠打造的「春之螢」、藝術家林國瑋的「Sweet Home」、黑川互動媒體藝術團隊的「花影漫步」、先驗物件藝術團隊的「 1960’2」。

▲由小松宏誠打造的「風之花瓣」,是本次活動最吸睛的代表作之一。(圖片來源:都市藝術工作室)

▲由小松宏誠打造的「雨之歌」,以雨滴在小水坑中激起漣漪的景象為靈感設計。(圖片來源:都市藝術工作室)

▲由小松宏誠打造的「森之夢」,燈箱投映出蝴蝶漫天飛舞的模樣。(圖片來源:都市藝術工作室)

▲台灣藝術家廖建忠打造的「春之螢」,模擬出無數螢火蟲飛舞的壯觀景象。(圖片來源:都市藝術工作室)

▲黑川互動媒體藝術團隊的「花影漫步」,用浪漫投影點亮整條步道。(圖片來源:都市藝術工作室)

▲先驗物件打造的「 1960’2」,呈現出時光隧道的意象。(圖片來源:都市藝術工作室)

▲台灣藝術家林國瑋打造的「Sweet Home」,是活動中的隱藏版作品!(圖片來源:都市藝術工作室)

社會學家兼紙刻藝術家魏少君也與東興圳旁邊的「六家國小」「興隆國小」共150位學童進行剪紙共創,將象徵新竹縣的五色鳥與茶花,還有台灣特有種寬尾鳳蝶等花草生物黏貼在燈球上,以繽紛色彩點亮公園步道。

▲由紙刻藝術家魏少君與在地學童共創的剪紙作品,全展示在一顆顆燈球上。(圖片來源:都市藝術工作室)

▲東興圳光藝節以「寫一首詩.給路上的風景」為主題,在展區也可以見到在地學童的二行詩作品。(圖片來源:都市藝術工作室)

▲在公園各處以及路面,也有各種光影作品,點亮每個角落。(圖片來源:都市藝術工作室)

看更多:全台最早燈會開跑!美拍「2萬盞彩繪燈籠海」刷新紀錄,周邊美食、景點推薦

市集、表演活動時間快筆記

「東興圳光藝節」期間特別規劃了週末限定活動,在1/18、1/19及2/14、2/15、2/16這5天,除了可以欣賞光影藝術外,還有市集及音樂、舞蹈等精彩節目,表演陣容包括日本高知「TACYON」yosakoi舞團、築夢舞集、在地3所國小學童表演及台灣特技團等。建議民眾可以選擇這幾天前往,體驗更豐富的光藝節活動內容!

▲1/18、1/19、2/14、2/15、2/16這5天在現場還有市集可逛。(圖片來源:東興圳光藝節粉專,圖為活動示意圖)

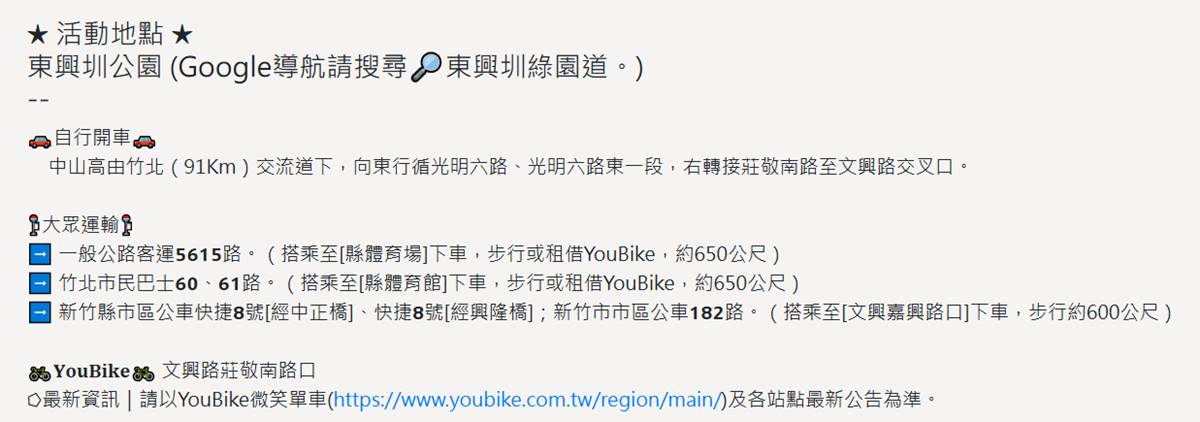

【交通方式】

抵達「東興圳公園」交通方式有很多,除了開車自駕,也可搭乘市區公車至鄰近站牌,再步行或租借YouBike前往。

▲主辦單位貼心附上多種交通方式,可輕鬆抵達活動現場。(圖片來源:截自東興圳光藝節官網)

【活動資訊】

2024-2025東興圳光藝節 寫一首詩 給路上的風景

日期:即日起~2025/2/16(日)

時間:每日17:30~21:30點燈

地點:新竹縣竹北市文興路及莊敬南路交叉口(東興圳公園)

官網:https://www.donxinglightartfest.com/

原文轉載來自:來源連結