700件商品任意混搭第2件5折

寵愛會員價天天省不必等 週週再抽五星奢華鐵道遊

醫美、面膜、衛生用品眾多好康 全面助力成就女王之路

春天來臨,伴隨著3/8國際婦女節將到來,健康美麗領導品牌屈臣氏鼓勵所有女性好好「愛自己」,2/22起至3/20,祭出多重好禮優惠,不論是女生最在意的外在美,還是每個月都會報到的生理期煩惱,都能在萬物復甦的春天由內而外帶給自己全方位呵護及寵愛,同時為幫民眾省荷包,屈臣氏也推出「美尬有春 一定要屈臣氏」700件商品任意混搭(不限同商品)第2件5折、小屈醫美賞、小屈膜法月、小屈棉棉月,另有美麗星期二、活力星期三等週間滿額贈活動。此外,寵愛會員不僅可獨享200支市場熱銷品會員價,消費不限金額再週週抽鳴日號-五星奢華鐵道遊(雙人套票/價值$35,600/共4組) ,消費次數越多,中獎機會越高,屈臣氏鼓勵每一位女性都能成為自己的女王。

醫美保養提升肌膚屏障

在緊接而來的季節轉換時期,氣候不穩定容易造成乾癢、敏感等肌膚狀況,令不少人感到困惱,這時不僅需提升肌膚屏障力,加強保濕度也是不可或缺的保養步驟之一,寵愛自己先從照顧臉蛋開始。為與民眾共同守護肌膚健康,屈臣氏推出「小屈醫美賞」優惠活動,凡購買醫美商品滿$1,500(折扣後)送$200(商品提貨卷)、滿$99(折扣後)再贈好禮,寵i會員滿$2500(折扣後)則享有$500(商品提貨卷),另外還有年度熱銷商品買一送一、年度熱銷組合包等好康優惠。

推薦商品:《CNP蜂膠能量彈潤精華液》、《德美醫研 原生粉嫩維他命B12精華》、《Dr.Satin魚子高水感保濕奇蹟乳》、《芮培菈 玫瑰果油乳霜》

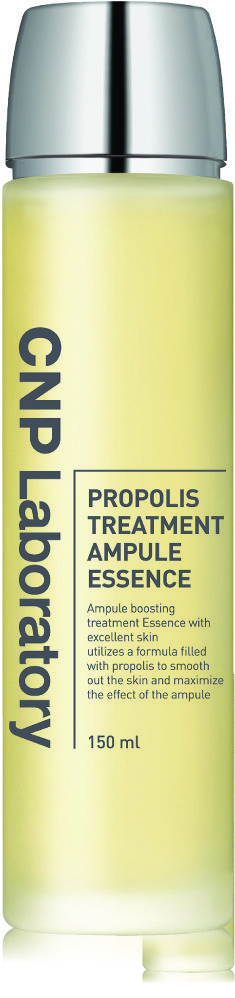

蜂膠能量彈潤精華液

原生粉嫩維他命B12精華

魚子高水感保濕奇蹟乳

玫瑰果油乳霜

保濕面膜補足流失水分

春季天氣逐漸升溫,強烈的紫外線使皮膚水分容易流失,此時透過敷面膜鎖水可以說是最好的時機,屈臣氏美容顧問建議使用成分天然、溫和的保濕面膜,並避免香料、酒精、過度控油等刺激成分,保養的同時也能夠讓自己好好放鬆。於小屈膜法月活動期間內,凡至屈臣氏購買10大面膜品牌滿$300(折扣後)憑卷折$100、萬片面膜憑卷週週領、精選面膜憑卷立享超低價、寵i會員獨享護膚商品消費滿$800(折扣後)贈好禮等優惠。

推薦商品: 《未來美 8分鐘PRO安瓶水潤面膜 3入》、《森田藥粧 多重玻尿酸複合精華高保濕面膜4入》、《La Pureté 極緻動能水導膜》、《黛若詩琳 透活膚追水膜 4片》

8分鐘PRO安瓶水潤面膜

多重玻尿酸複合精華高保濕面膜

極緻動能水導膜

透活膚追水膜

放鬆情緒舒緩經期不適

除了保養肌膚外,春天的氣候多變也容易影響心理,導致精神緊張、情緒不穩,對於不少生理期時常不適的女孩更是加倍困擾,屈臣氏專業藥師建議除了改善熬夜、刺激飲食等不良習慣,假日到戶外踏青、放鬆心情也對經期不適頗有助益,同時應避免私密處長時間處於悶熱環境,養成日常清潔保養習慣,讓私密處整天維持清爽潔淨。為了不讓生理期影響好心情,屈臣氏推出「小屈棉棉月」優惠,於活動期間至屈臣氏購買單包衛生棉/護墊/棉條第2件5折、購買衛生棉/護墊/棉條/女性私密清潔用品滿$388(折扣後)再贈好禮。

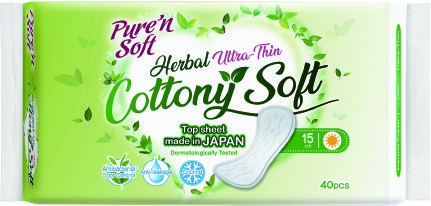

推薦商品: 《靠得住 草本抑菌加強版》、《Pure’n Soft草本涼感超薄棉柔透氣護墊》、《蘇菲 導管式棉條》、《好自在 熊抱安睡褲》

《「美尬有春」推薦商品》

醫美保養 提升肌膚

CNP

蜂膠能量彈潤精華液150ml

原價$1,150

特價$863

德美醫研

原生粉嫩維他命B12精華 30ml

★屈臣氏獨家★

★屈臣氏新品★

原價$1,350

特價$790

Dr.Satin

魚子高水感保濕奇蹟乳120g

★屈臣氏獨家★

原價$1,380

年度熱銷買1送1平均單件$690

芮培菈

玫瑰果油乳霜125ml/100%純玫瑰果油15ml

★屈臣氏獨家★

特價$939

兩件$1,699

平均單件$850

保濕面膜 補足流失水分

未來美

8分鐘PRO安瓶水潤面膜 3入

★屈臣氏獨家★

原價$399

特價$266

700件商品任意混搭第2件5折

平均單件$200

森田藥粧

多重玻尿酸複合精華高保濕面膜4入

★屈臣氏獨家★

原價$239

特價$160

700件商品任意混搭第2件5折

平均單件$120

La Pureté

極緻動能水導膜 6入

原價$980

700件商品任意混搭第2件5折

平均單件$735

Dazzleslim黛若詩琳

透活膚追水膜 4片

原價$488

700件商品任意混搭第2件5折

平均單件$366

放鬆情緒 舒緩經期不適

靠得住

草本抑菌加強版日薄23cm 12片

原價$125

特價$69

700件商品任意混搭第2件5折

平均單件$52

Pure’n Soft

草本涼感超薄棉柔透氣護墊15cm 40片

★屈臣氏獨家★

原價$129

特價$85700件商品任意混搭第2件5折

平均單件$64

好自在

熊抱安睡褲 L 4片

原價$199

特價$169

700件商品任意混搭第2件5折

平均單件$127

標題:迎接春天新氣象 從呵護自我開始 屈臣氏祭出「美尬有春」多重優惠 鼓勵女性做自己的女王

鄭重聲明:本文版權歸原作者所有,轉載文章僅爲傳播更多信息之目的,如有侵權行爲,請第一時間聯系我們修改或刪除,多謝。