即便相對於燃油車及油電車的強勢,TOYOTA在純電領域的表現仍較為保守,但對於產品的布局及基本競爭力仍持續關注。針對目前台灣唯一一台販售的TOYOTA純電車款bZ4X,總代理和泰汽車在官網放上全新年式資訊,除了產品價格維持167萬外,同步升級安全配備及辨識銘牌,今年更有望與最新純電都會休旅城市巡洋艦攜手,強化純電休旅陣容。

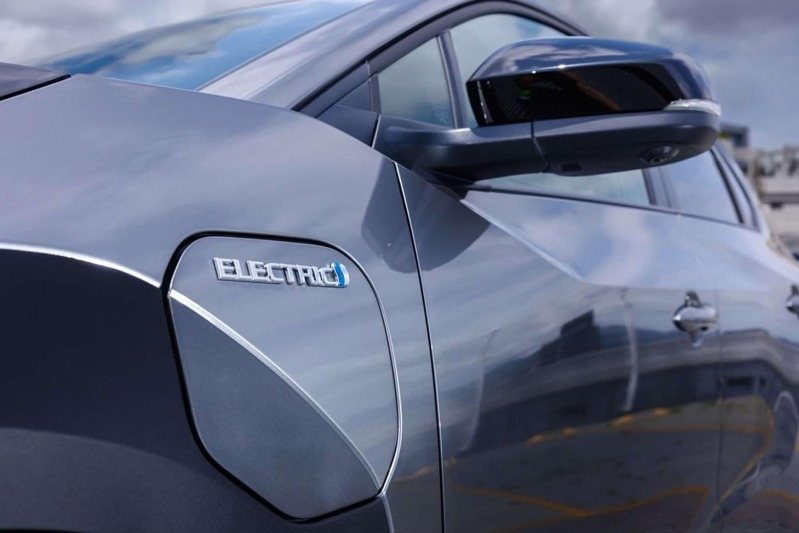

其中新年式車款在外型上的最重要轉變,是在外觀前葉子板與充電孔,由過去的Electric字樣,更換為Beyond Zero BEV字樣識別,藉此符合近年來TOYOTA品牌對於新能源車的識別。

此外,主動安全配備部分也做出升級,新增SEA安全離座警示,有助於在乘客下車時提醒後方有無來車,減少因為開啟車門產生的交通意外。

去年bZ4X整年度販售為299輛,佔TOYOTA在台銷售相當有限,主力銷售仍以一般燃油車及油電車為主,但今年台灣市場有望迎來Suzuki e Vitara的雙生車款TOYOTA Urban Cruiser,尺碼更小的都會純電休旅車型,預期開出更入門的價格,有望進一步強化TOYOTA的純電佈局。

原文轉載來自:來源連結