記者劉宛欣/綜合報導

網紅奈奈子(Koori)因天使臉孔火辣身材在網路上小有名氣,先前被週刊踢爆陪睡已婚富商,還找姐妹一起加入組成後宮團,惹火正宮。奈奈子沉寂兩周後,終於在社群平台發文澄清,強調這些指控全屬「子虛烏有」,還拍影片喊冤,稱富商只是她當直播主時的「榜一」,此舉再度惹怒正宮,放話歡迎她提告。知名律師李怡貞在看完影片後,也在臉書吐槽奈奈子「活得比飛機杯不如」。

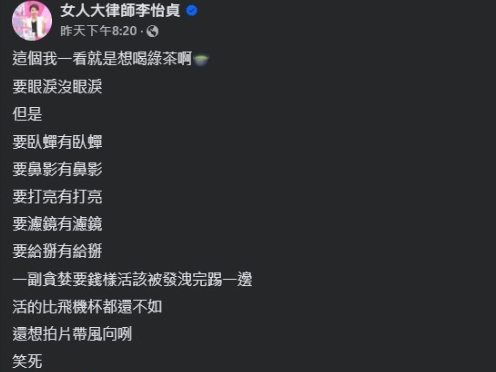

李怡貞經常在臉書發文討伐各路小三,這次奈奈子事件她也關注了內容,在看完奈奈子的澄清影片後,開酸「這個我一看就是想喝綠茶啊,要眼淚沒眼淚,但是要臥蠶有臥蠶、要鼻影有鼻影、要打亮有打亮、要濾鏡有濾鏡、要給掰有給掰」,接著還直言批評道:「一副貪婪要錢樣活該被發洩完踢一邊,活得比飛機杯都還不如。」認為奈奈子拍片只是想要帶風向。

此前,奈奈子在被週刊爆出「4女共侍1夫」的風波後,沉默2周終於發聲回應,指出所謂的「富商」其實只是一位「榜一」支持者,對方常在她直播時積極互動,因事業不順,曾多次向她訴苦,她基於「曾幫助過自己」的情誼維持聯繫,怎料對方開始情緒勒索,她選擇封鎖並斷絕往來。

不只如此,奈奈子透露該男因涉嫌走私毒品,早已在人間蒸發,兩人至少半年以上未聯絡,對於週刊報導中提到的溫泉聚會,她解釋另外3名女子是透過男方介紹認識,自己泡湯後就搭車離開,並未如報導所述「提供服務」。面對醜聞重創,奈奈子坦言,這段期間如同地獄,每天活在眼淚和焦慮中,幾乎快把她壓垮,不得不求助身心科治療,表示已蒐集相關證據,將對不實報導及網友不當留言採取法律行動。

標題:奈奈子拍片喊冤!律師李怡貞開酸「一看就綠茶」:活得不如飛機杯

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。