陳都靈的美麗不容置疑,在校期間她無疑是校園的寵兒,畢竟能夠成功闖入娛樂行業的人,誰不具備一定的外貌條件呢?

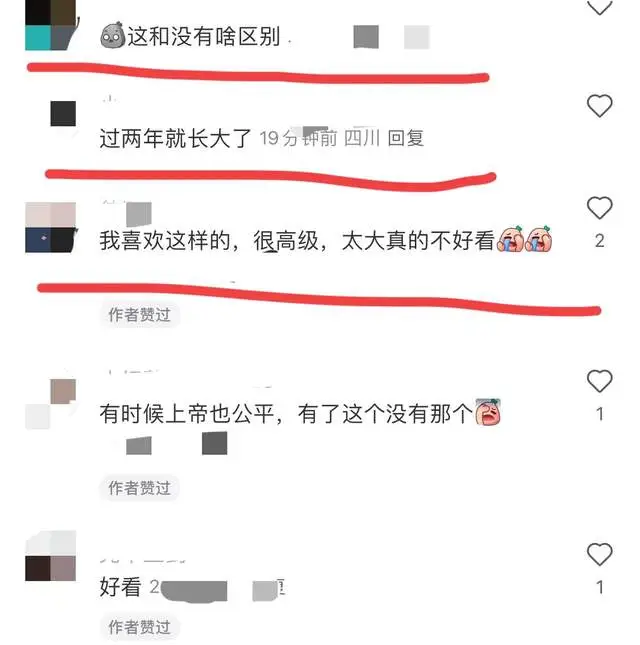

近日,陳都靈作爲內衣廣告的模特,展示了她的完美身材,然而這次拍攝卻引發了不少網友的評論與質疑。許多網友對此表示不滿,認爲廣告中的呈現與她的形象並沒有太大區別,直言不諱地提出了自己的看法,甚至有人覺得這樣的表現顯得略顯平庸。

然而,反對的聲音並非全部。還有部分網友認爲,陳都靈的這種展現實際上相當高級,盡管風格與某些傳統審美存在差異,但正是這種獨特的氣質在廣告中顯得尤爲突出,展現了一種新穎的美感。

衆所周知,商家選擇陳都靈作爲代言人並非偶然,背後必然有其深思熟慮的考量。一方面,她本身就具備較高的人氣和知名度,對於品牌曝光度有着顯著的提升作用;另一方面,隨着大數據的發展,企業在推廣及選用代言人時的決策已經越來越科學,能夠根據市場分析得出精准的結論,這種選擇無疑是經過充分驗證的做法。

展開全文

在當今社會,關於身材的標准常常被模糊化,許多女孩的身材與陳都靈相似,但大家並不一定都能達到那些被廣泛認爲的“完美”身材標准。並不是所有女生都能夠像柳巖那樣擁有引人矚目的身材,實際上每個人都有自己獨特的體態和魅力。

究竟什么才是“好身材”的標准?這個問題的答案存在着千差萬別。不同的人對美的理解和感受各有不同,有的人十分追求修長的身材线條,有的人則鐘情於豐腴的曲线。或許在這個多元化的時代,最重要的並不是外在的審美標准,而是每個人內心對自身的認同與接受。

自信、美麗、健康,或許是更值得追求的目標。在這樣的環境中,能夠認清自我,懂得欣賞自身的優點,是一種難得的能力。每個人身上都有閃光點,或許一個微笑、一個動作、一種態度都可以成爲她們獨特之處。重要的是,我們終究應該以开放的心態去面對多元的美,無論是肆意展現的風格,還是平易近人的氣質,都值得我們欣賞。

在社交媒體日益發達的今天,審美更加多元,公衆的接受程度也愈加寬廣。陳都靈以她的方式詮釋了這一點,盡管她的廣告受到了一些爭議,卻也從側面反映了觀衆對美的不同見解和期待。她的身材對於某些人來說,恰恰是他們所渴望追尋的狀態,即便不是絕對的標准,依然引發了許多人的共鳴。

總之,陳都靈的身材之所以受到如此關注,是因爲在這個滿是審美標准和偏見的時代,她展現出了自己的獨特魅力。不論外界評論如何,最重要的是,她能夠以自信的姿態面對自己乃至這個時代對於身材的各種追求。當下,女性的美麗已不再局限於單一的身材模特,能夠展現個性、態度與自我的美麗,才是最值得追求的目標。正如她自己那樣,選擇做真實的自己,堅信無論外在如何,內在的美才是永恆的追求。

標題:31歲陳都靈逆生長?內衣廣告身材火辣,網友:不敢相信!

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。