輕裸透亮當道:2025春夏彩妝趨勢解析

隨著2025春夏時尚逐漸揭幕,彩妝重點聚焦於自然與亮澤的融合,清新裸妝、自然感成為核心概念,搭配璀璨流光眼影、夕陽橙暈感腮紅及柔和魅影煙燻妝,營造多層次妝容美感;脣妝則以低飽和色系與光澤為亮點,透亮水光脣彩則為整體妝容增添奢華質感。台灣第一彩妝品牌1028全新推出《脣脣欲凍持色水光脣釉》、《放色線激穩抗震眼線液-濃巖灰》與《睫對翹睫毛夾》,完美呼應早春妝容潮流,讓妳在2025年初即擁有動人神採!

水光嘟脣新體驗:凍人心弦的脣情魅力

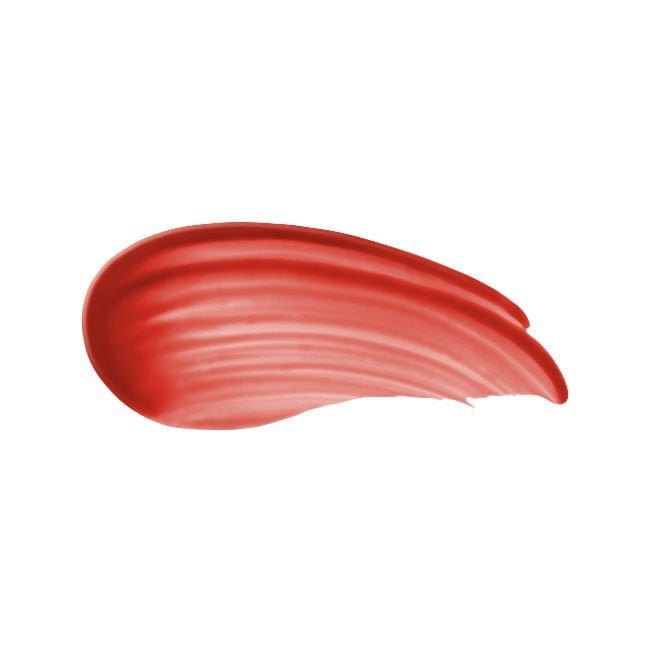

在流行大勢的推動下,水光感脣妝持續熱潮不減,脣脣欲凍持色水光脣釉蘊含高保濕三重精華配方,潤澤雙脣更顯澎彈;質地輕盈貼脣且絲滑不黏膩,打造出沁透凍感的嘟嘟美脣,一秒即現「水光嘟脣」,高持色續航力與自然潤澤,只需一抹即能速成薄膜效果,不易掉色並隱匿脣紋不拔乾,同時添加微微果香,香嫩欲滴的雙脣絕對讓人忍不住想親一口!推出六款色選滿足不同場合需求:日常裸感#101杏桃果凍、慵懶個性#102肉桂果凍、氣質少女#103玫瑰果凍、溫柔百搭#104豆沙果凍、去黃顯白#105烏龍果凍以及紅潤氣色#106甜荔果凍;多層次疊加使用,能帶出更加迷人的光澤與色彩表現,讓妳輕鬆駕馭各種場合!

眼技無懈可擊:色彩搭配工具聯手出擊

眼妝作為彩妝的靈魂,放色線激穩抗震眼線液與睫對翹睫毛夾是打造魅力雙眸的必備工具。受到眾多美妝手還有消費者喜愛的放色線激穩抗震眼線液,今年推出新色濃巖灰,灰階眼線成為偽素顏與清秀妝容的關鍵,霧灰黑色調不僅低調自然,更能畫出柔和深邃的眼妝。其0.01mm柔彈筆尖易於均勻勾勒,加上穩定抗震的筆身設計與抗暈微膜包覆技術,讓妳輕鬆掌握細緻完美眼妝。要讓眼妝更添靈動,少不了一款好用的睫毛夾,睫對翹睫毛夾以升級弧面貼合眼型,搭配高彈力膠墊設計,讓睫毛輕鬆一夾即翹,配合省力握柄與精準手握受力,打造根根分明且捲翹持久的睫毛效果。眼線液與睫毛夾的絕妙搭配,讓你的眼妝瞬間升級,魅力神採難以抗拒!

完美彩妝啟程:早春妝容的無限可能

2025年的早春妝容,不僅是一場彩妝潮流的風向標,更是一種展現自我風格的方式。從水光透亮的脣釉,到自然柔和的灰色眼線,以及捲翹有型的美睫,1028脣脣欲凍持色水光脣釉、放色線激穩抗震眼線液與睫對翹睫毛夾幫助妳掌握每一細節,讓每一天都是妳的時尚伸展台,1028為你打造妝容的無限可能!

脣脣欲凍持色水光脣釉

澎潤撫紋 凍感水光嘟脣

-蘊含高保濕三重精華配方,高保濕澎潤,隱匿脣紋不拔乾

-極輕盈貼脣,絲滑疊刷不位移、不黏膩

-凍感高光澤,飽滿嘟嘟水光脣

-速成膜持色,持久續航不易掉

-

#101杏桃果凍

-

#102肉桂果凍

-

#103玫瑰果凍

-

#104豆沙果凍

-

#105烏龍果凍

-

#106甜荔果凍

1028

脣脣欲凍持色水光脣釉

放色線激穩抗震眼線液-濃巖灰

開架熱銷眼線液新色登場

-激穩抗震,流暢不失手

-0.01mm激細筆尖,細緻不斷線

-鎖色定型,無縫隙飽和發色

-零暈染不掉色,耐皮脂

1028

放色線激穩抗震眼線液

睫對翹睫毛夾

捲翹美睫的祕密武器

-弧面升級更貼合,一夾即捲翹

-高舒適柔彈膠墊,輕夾不斷睫

-輔助彈簧+省力握柄設計,操作不費力

-兩指定位好掌控,速夾好上手

1028

睫對翹睫毛夾

標題:【1028】2025春妝趨勢:輕裸自然展現自信風採,從眼彩到脣妝,1028打造屬於你的美眸嫩脣 /

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。