[ad_1]

文章作者:李炎宗

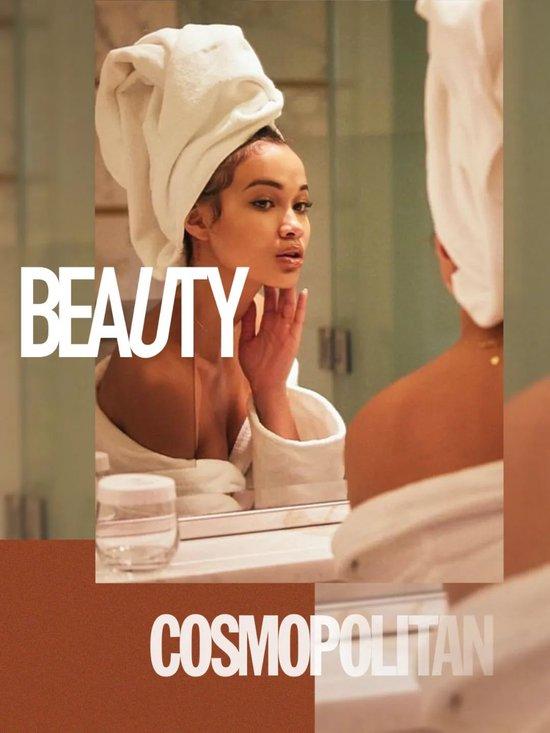

文章來源:時尚COSMO 微信公衆號

錢沒少花,

爲什么護膚效果總差點意思!

護膚品买了多少?

每天護膚的時間佔了多久?

相信大部分女生的答案都是:“錢沒少花!時間沒少用!”但爲什么總感覺護膚效果跟付出不成正比?

今天,我們就來聊聊那些護膚路上的“絆腳石”,以爲是捷徑、其實山路十八彎的護膚誤區。

所謂基礎護膚至少也包括“清潔-防曬-保溼”三大部分,對於皮膚來說是最基本的護理(就像解決溫飽問題,但是足夠的功效性完全談不上)。

如果本身皮膚正處於敏感期、爆痘期等特殊階段,有刺、癢、紅、腫、熱等症狀,這種特殊時期只做好基礎護膚是ok的,因爲皮膚的狀況不穩定有炎症、需要時間等它恢復到正常的健康狀態,就像生病了需要清單飲食+休息一樣的道理。

不過正常皮膚只做基礎護理的話,是遠遠不夠的(除非你對皮膚狀態的要求比較少),護膚品並不是抹得越多越傷皮膚,除非用了不適合的產品。在大方向上,白天做好防曬+抗氧化,晚上按自己當下的皮膚需求,做好亮白淡斑、緊致抗老或者舒緩修護等不同功效的保養。

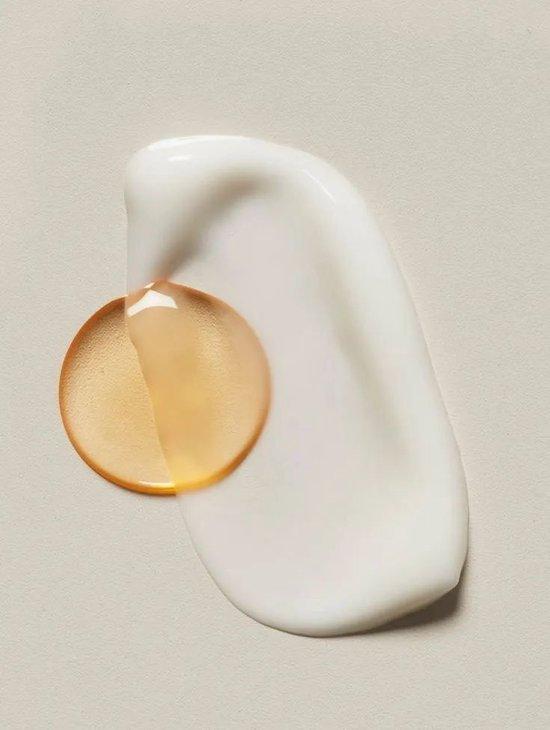

可能是因爲精華的價格比較貴,很多人就覺得精華比面霜更重要。其實它們完全是兩個品類,發揮的作用也各有不同,很難放在一起進行比較。

精華擁有質地相對輕薄、滲透性更好、某種功效性成分濃度添加更高的特點。它一般在面霜之前使用,後續需要面霜或乳液的覆蓋、及時上一層保護膜。這樣做的原因是面霜或乳液中都含有油脂類成分,它能在皮膚表層形成保護強化皮脂膜功能,防止水分流失,減少精華中有效成分的氧化損失,讓它們持續高效的發揮功效性作用。

所以精華並不比面霜更重要,而是塗抹精華後一定要用面霜或乳液,如果預算有限非要極限二選一的話,那可以买一瓶功效性的面霜。

貴婦們也並非是錢多人傻,再貴的產品無效不好用也是沒有市場的。

其實所謂貴婦護膚品的定位,是在滿足護膚功效性的同時還能提供愉悅的使用感受(包括產品外觀、香味、膚感等各種感官體驗),品牌形象和VIP會員服務等提供的情緒價值、甚至提供定制服務……所以它的高定價是除了產品好用之外還包括這一系列的附加值。

我們可以說貴婦護膚品談不上有性價比,但說它是智商稅也是不至於。追求護膚性價比的小夥伴,也是有很多品牌可以選擇的,不管你的預算是一百還是一千,都能挑到適合的產品。

有一些紋路是可以通過護膚來改善的,比如幹紋、眼周的表情紋等。但是像法令紋、印地安紋它們的形成是由於韌帶、軟組織的結構問題造成的,則是另一碼事了。

法令紋也叫鼻脣溝,有人是因爲鼻基底凹陷造成的、有人是因爲面中部軟組織下移擠壓造成的;而印地安紋看似淚溝的延長,其實是因爲皮膚和顴骨之間的顴皮韌帶太緊或韌帶旁的組織疏松造成的,很多小朋友天生就有,這些紋路靠表層的護膚是完全沒有辦法改善的。

此外還有脂肪型眼袋、木偶紋等也是,這些問題去尋求正規的醫美治療更靠譜,我們對護膚品的功效要有理性認識,不要過度的理想化就不會被割韭菜!

篇幅有限總結了幾個我自己工作中常被問到的幾個問題,各位小夥伴還有什么護膚上踩過的雷、走過的彎路也來分享一下吧,幫其他人避避險,大家一起在高效護膚的道路上越來越美。

圖片來源:Ins / Pinterest

標題:精華和面霜哪個更重要? 這些護膚誤區你必知

鄭重聲明:本文版權歸原作者所有,轉載文章僅爲傳播更多信息之目的,如有侵權行爲,請第一時間聯系我們修改或刪除,多謝。

[ad_2]