記者蕭採薇/綜合報導

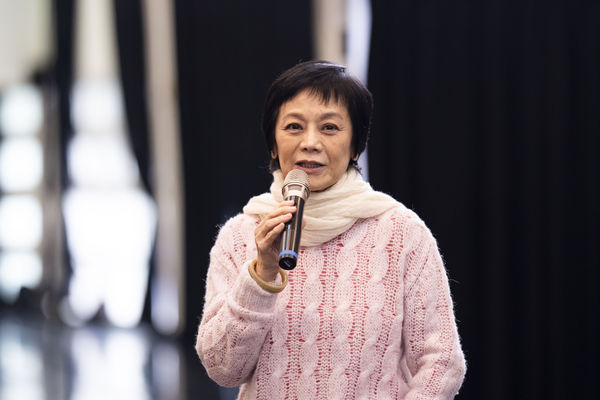

金馬影後張艾嘉日前受訪時,鬆口「想退休」,讓影迷非常扼腕。對此張艾嘉澄清,是要做更多幕後的事,像是她致力於「果實藝術創作營」的《星‧梁祝的繼承者們》計畫,明年也將會開始準備新作品的劇本。

張艾嘉創辦果實文教基金會36年,以藝術啟發年輕人的夢想,舉辦「果實藝術創作營」,培養超過600位高中青年。今年特別邀請知名導演林奕華、音樂製作人陳建騏、香港芭蕾舞團藝術總監伍宇烈等創作導師群指導。《星‧梁祝的繼承者們》計畫,邀請所有參加過創作營的學員進行甄選,預計明年8月於PLAYground空總劇場正式演出。

「果實藝術創作營」每年招40位高中學子,透過7天密集的舞蹈、戲劇、音樂歌唱、繪畫等藝術訓練,15年來已有非常多學員投入於藝術相關創作領域,今年擴大舉辦《星‧梁祝的繼承者們》計畫,就是為了讓學員們能藉由國際級大師的專業訓練,提升自我能力及啟發對藝術更深層的認識。

張艾嘉表示,家喻戶曉梁祝故事,適合參與這個計劃的學員,每個人都是梁山伯、每一個人都是祝英台,就像是年輕人自我探索與學習的過程。這次《星‧梁祝的繼承者們》計畫耗資千萬,打造破天荒的高規格師資陣容,更希望金融業或是對於藝術有興趣的基金會可以一起加入這個計畫。

對於張艾嘉邀請林奕華導演參與這個計劃,林奕華毫不思索地表示:「我怎麼可能不答應,這個作品圍繞年輕人、教育與生命的主題,如果能夠過這個機會,讓年輕人去接觸到更多的未來,對小果實們來說是一個很好的禮物。」

標題:張艾嘉鬆口「想退休」曝下一步計畫 一件好事堅持36年培養600人

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。