12月8日,2024賽季F1收官战——阿布扎比大獎賽正賽如約而至。和往常通過網絡平台觀賽不同,這次我來到了位於北京王府井中環的IWC萬國表精品店,和衆多IWC萬國表的朋友們,一起线下觀看了這場F1收官战。

下面,我們就以這場觀賽活動獲得的一件小獎品,來开始今天的話題。

鋮品介紹

這是一盒樂高積木,機械組,編號42165。相比超級賽車系列,機械組在細節方面做得更好,顆粒數也更多、尺寸也更大。特別是加入了“回力”系統,讓賽車模型不光可以靜態欣賞,還有了一定的可玩性。

正面包裝是一輛梅賽德斯-AMG F1 W14賽車,全黑的車身伴有一些馬石油綠的點綴,看上去很協調。機械組就沒有人仔了,喜歡人仔的朋友們可以考慮超級賽車系列,同樣也有梅賽德斯-AMG F1的賽車款可以選擇。

展開全文

背面包裝,是賽車模型側後角度的照片,左下角還有一張F1賽車的實車照片,只是車上沒有賽車編號。最終拼完的成品,也是沒有賽車編號的。

打开包裝盒後,一共有四個編號小袋,1小時就拼完了。整輛賽車的貼紙還不少,這就是F1賽車,許多贊助商同時出現在同一台車上,還能營造出一種和諧的獨特風格。

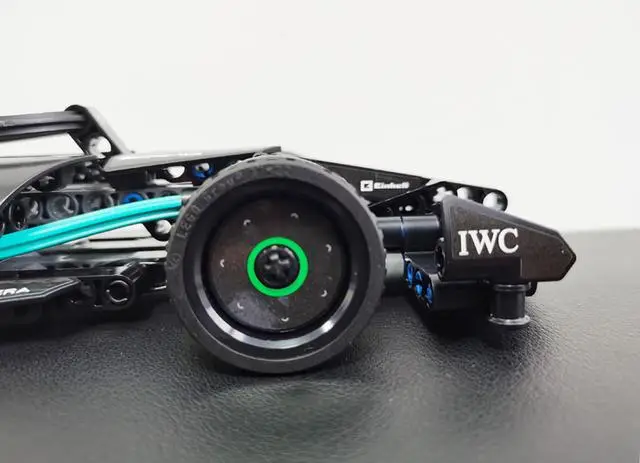

在細節方面,前翼兩側的IWC萬國表標識還是非常顯眼的。

賽車模型的HALO系統採用了橡膠材質,彈性和延展性更好,還巧妙融合了奔馳品牌LOGO,前部機艙的兩側還有AMG的標識。

賽車模型的側後方,可以看到奔馳經典的星輝標識,這和奔馳近些年常用的設計元素,很具有品牌辨識度和設計感。

尾翼上有車隊主贊助商馬石油的英文標識,可惜無法實現DRS的翻動效果。

賽車的“回力”系統,主要是因爲有一個“發動機”模塊,讓這輛賽車模型成了回力車,實際體驗還是挺好玩的。

中國首家賽車主題的IWC萬國表精品店

位於北京王府井中環的IWC萬國表精品店,是品牌在中國的首家賽車主題精品店。進入到店內,首先映入眼簾的就是那台梅賽德斯-AMG F1 W15賽車,這是2024賽季梅賽德斯-AMG車隊徵战F1賽場的同款。

銀箭車身上的44號賽車編號,證明了其正是“七冠王”漢密爾頓的座駕。能夠如此近距離接觸到這款賽車,對於賽車迷來說,確實很難得。

近兩年關注度極高的IWC萬國表工程師系列,在精品店裏也有專門的展區,還有表盤、表殼、機芯、表帶等工藝的展示,能夠鑑賞到從原始材料到成品零件的制表過程。

值得一提的是,精品店還可以個性定制葡萄牙系列計時腕表,有特殊表盤和個性表帶的可供選擇,打造出獨一無二的“葡計”,適合追求個性的朋友。表盤上六點鐘的小圈有一個字母“I”,可以與非定制版進行區分。

收官战,亦是告別站

2024賽季的F1收官战,看點頗多。首先邁凱倫和法拉利的車隊總冠軍之爭,還有一些懸念;中國車手周冠宇的最後一場比賽,下賽季在F1賽場可能就看不到周冠宇了;這是賽恩斯在法拉利車隊的最後一站,也是漢密爾頓在梅賽德斯-AMG車隊的最後一站。

最後的結果,大家都知道了。諾裏斯拿下收官战的冠軍,邁凱倫獲得了年度車隊總冠軍;法拉利車隊的兩位車手賽恩斯和勒克萊爾,分獲亞軍和季軍;梅賽德斯-AMG車隊的漢密爾頓和拉塞爾位列第四和第五。

在賽季之初,我們就都知道這是“七冠王”漢密爾頓在梅賽德斯-AMG車隊的最後一年。正所謂,“天下沒有不散的宴席”,既然已是既定的事實,作爲賽車迷好好觀看比賽,感受賽車的樂趣就挺好。IWC萬國表組織线下觀賽,也是告別漢密爾頓的一種特別方式。

漢密爾頓和他的IWC萬國表

IWC萬國表和梅賽德斯-AMG的官方合作,最早可以追溯到2004年,距今正好是20周年。2013年,IWC萬國表成爲了梅賽德斯-AMG F1車隊的官方合作夥伴,於是銀箭賽車上就有了IWC的標識。

2013年起,IWC萬國表就和梅賽德斯-AMG推出了多款聯名腕表,深受廣大車迷和表迷的追捧,尤其是“七冠王”漢密爾頓上手同款,天生就有着超高的人氣和話題。目前,如果大家想購买“七冠王”漢密爾頓同款腕表,有兩款是值得一看的。

今年F1英國大獎賽,漢密爾頓拿下了正賽冠軍。時隔945天,漢密爾頓終於再次登上了最高領獎台,佩戴IWC萬國表親吻獎杯的那一刻,也成爲了F1圍場裏的“歷史名畫”。

漢密爾頓佩戴的是IWC萬國表飛行員系列高性能計時腕表41 “梅賽德斯-AMG馬石油F1車隊”特別版(型號:IW388306)。該腕表採用了IWC萬國表自主研制的瓷化鈦金屬材質表殼,這種創新材質既有鈦金屬的輕盈,又具備類似陶瓷的硬度和抗刮能力。和傳統飛行員計時腕表不同,這枚腕表配有測速刻度的陶瓷表圈,能夠根據經過的距離測算出車輛的平均時速。

整體黑色的主色調,與梅賽德斯-AMG車隊的隊服顏色相呼應,輕盈的外殼搭配黑色的橡膠表帶,能夠帶來輕盈的佩戴舒適感。機芯方面,採用的是IWC萬國表自制的69385型機芯,動力儲備爲46小時,防水深度爲100米,透過透明藍寶石玻璃表背即可欣賞機芯的工程美感。

今年10月,在瑞士蘇黎世舉辦的2024勞倫斯體育公益基金會“慈善之夜”上,這枚具有歷史意義的腕表和漢密爾頓原版籤名手套一同拍賣,中標金額爲22萬瑞士法郎(約合179.3萬元人民幣)。自2005年起,IWC萬國表一直是勞倫斯體育公益基金會慈善活動的全球合作夥伴,拍賣所得款項將全部捐贈給基金會,用於支持基金會旨在通過體育運動改善兒童和青少年生活的項目。

第二款腕表是2022年推出的飛行員計時腕表41“梅賽德斯-AMG馬石油F1車隊”特別款(型號:IW388108),經典的“飛計”採用了5N級鈦材質表殼,黑色表盤搭配馬石油綠元素,顯示清晰直觀,很容易讓人聯想到梅賽德斯-AMG F1賽車塗裝。機芯方面,同樣採用了69385型機芯,有背透,在此就不再贅述了。

這是IWC萬國表爲“梅賽德斯-AMG馬石油F1車隊”研發的首款官方車隊腕表,車隊的每一位成員都擁有這枚腕表。比較難得的是,這款腕表配備了兩條表帶,分別是一條黑色壓花小牛皮表帶,表帶縫线是馬石油色的;另一條是馬石油綠橡膠表帶,借助集成式簡易更換系統,只需按下按鈕即可輕松更換表帶,實現真正的徒手快拆。

這款腕表是筆者朋友圈好友近些年購买最多的IWC萬國表,沒有之一。不用聽別人吹噓,消費者拿真金白銀投票的,才是真的好作品,這也是我推薦這款腕表的主要原因之一。

最後扯扯

一轉眼,12月已經過半,2024年即將結束。無論是汽車行業,還是鐘表行業,都發生了很大的變化。明年,IWC萬國表和梅賽德斯-AMG的官方合作還將繼續,在期待明年車隊能取得好成績的同時,我們也期待IWC萬國表能推出更多驚豔的作品。

最後,布拉德·皮特主演的電影《F1》計劃於2025年夏天正式上映。這部以F1爲主題的電影,從官方宣傳海報和預告片中,我們都可以看到IWC萬國表的身影。作爲賽車迷,電影《F1》定然是不容錯過的,可以期待一下。

標題:鋮品記丨在有F1賽車的鐘表店裏,看F1收官战是什么體驗?

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。