記者項瀚/台北報導

公館65年麵包名店「得記烘焙」無預警歇業,引發熱議,不少人在猜歇業原因與租金有關。不過在地人駁斥,透露房東就是得記自家人。經查,得記老闆姓陳,公司就登記在該店面,而店面由3位陳姓自然人分割繼承取得多年,戶籍登記在文山、新店一帶豪宅。

▲公館65年麵包名店「得記烘焙」無預警歇業,引發熱議。(圖/記者項瀚攝)

「得記烘焙」主打台風歐式麵包,香蒜法國麵包為許多老饕心中的經典,該店擁65年歷史,卻在近日無預警歇業,讓人相當震驚,引發各大媒體報導。

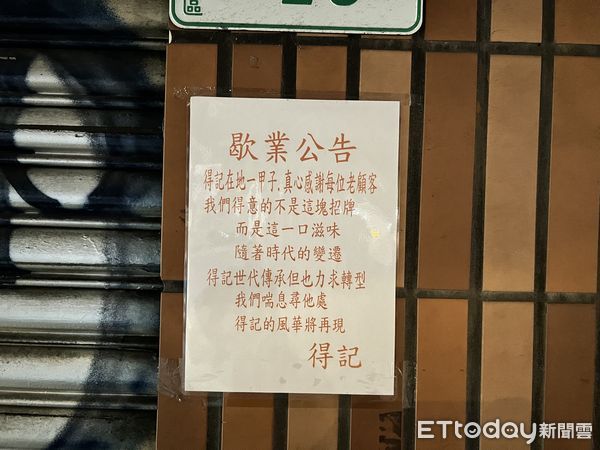

店門口張貼公告:「得記在地一甲子,真心感謝每位老顧客,我們得意的不是這塊招牌,而是這一口滋味,隨著時代的變遷,得記世代傳承但也力求轉型,我們喘息尋他處,得記的風華將再現。」這讓不少人在猜,歇業的原因與租金高漲有關,並認為會在其他點位繼續營業。

▲65年老店「得記」張貼公告,無預警歇業。(圖/記者項瀚攝)

不過《ETtoday新聞雲》聯繫到台大公館商圈發展促進會理事長周麗華,她說:「那是得記自己的房子,歇業跟租金無關,不要亂傳啦!應該是老闆年紀大了,沒人接手。」

經查,「得記食品」公司登記地就在公館店面,負責人為陳國富。再查謄本,該店面由3位陳姓自然人共同持有,在20年前就以分割繼承取得,他們3人戶籍登記在新店、文山一帶豪宅,有藝人加持的社區大樓,也有華城一帶的透天。記者致電得記食品公司,但沒人接聽電話。

事實上,「得記食品」位於3層建物,而該建物1樓加上2~3樓整層空間過去為星巴克,也是當地地標,但在2023年底熄燈。觀察目前《591房屋交易網》,暫無出現該棟建物的招租資訊。

住商不動產師大永康加盟店東江建欣表示,「得記烘焙」位於公館心臟地帶,鄰近捷運站出口,旁邊又是羅斯福路四段24巷,非常熱鬧,且該店面座落三角窗,面寬夠,曝光效益佳,過去樓上是星巴克,屬公館商圈地標點位。

江建欣認為,「得記烘焙」1樓租金單價可達8000~1萬元水準,以謄本資訊1樓面積約39坪來看,每月挑戰近40萬元有機會,不過公館商圈屬北市二級商圈,目前整體空置率略高,房東在招租上仍會感到壓力。

江建欣補充,「得記烘焙」也不排除連同過去星巴克2~3樓空間,也就是整棟出租的可能性,樓上租金單價約是1樓的4~5折,但整棟物件產品特殊、面積大,整體租金較難預測。

▲歷年羅斯福路四段租金單價破8千交易。(表/記者項瀚製)

標題:公館65年得記麵包歇業 在地:房東是自家人「與租金無關」

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。