(中央社記者謝靜雯台北18日電)大專棒球聯賽(公開一級)8強出爐,台灣體大今天預賽終戰與輔仁大學交手採投手車輪戰,8局下靠著失誤跑回致勝分,以4比3搶下預賽第9勝晉級;中信科大以3比2擊敗美和科大擠進8強。

113學年度大專棒球聯賽(公開一級)最後一日賽程,台灣體大今天與輔仁大學交手,台體大3局下靠著失誤、高昱希安打推進,2人出局後補上陳柏儒安打攻佔滿壘,滿壘時先靠觸身球保送擠回1分,凃昱豪安打、一棒再添2分。

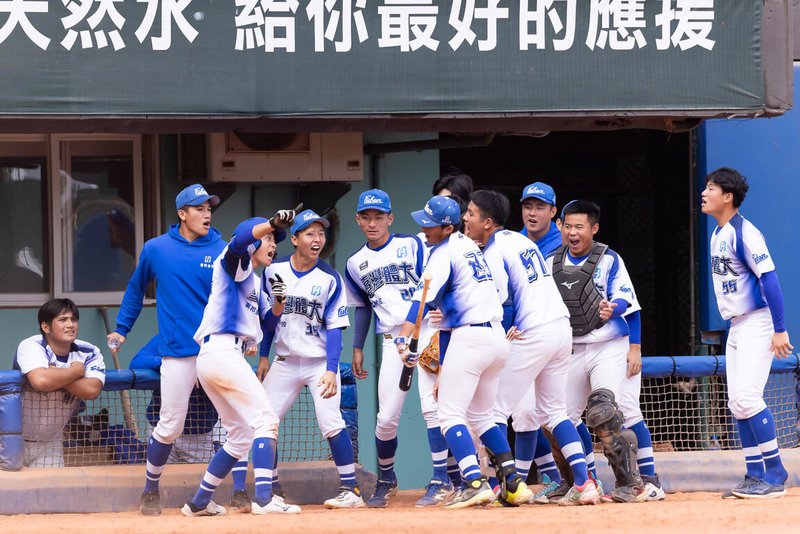

輔仁大學6局上追回3分、扳平比數,8局下台體大再起攻勢,高昱希率先敲出二壘打,陳昶宇犧牲觸擊造成對手守備失誤、高昱希跑回致勝分,台體大順利搶下預賽第9勝(6敗)、晉級8強。

台體大今天由日籍投手深見一騎先發投2局,張宸綱、李樹勳、劉建利、陳善宇、戴昱峰、洪庭文、洪晨勛依序登板,僅陳善宇失掉3分(2分責失分),勝投記在戴昱峰身上。

中信科大今天與美和科大交手,中信科大一度1比2落後,6局下靠著安打、失誤、張凱鈞代打建功,適時安打、一棒送回2分、超前比數,率隊以3比2搶下預賽第9勝(6敗)晉級。

嘉義大學今天與明新科大交手,嘉義大學投手呂泰運先發投7局僅被敲出3支安打,投出1次三振、無失分,好投壓制率隊以4比0搶勝,預賽戰績8勝7敗,與崑山科大、台北市大戰績相同,比較對戰關係後,嘉義大學搶下最後一張8強門票。

大專聯賽8強晉級隊伍確定,為南華大學、國立體大、輔仁大學、文化大學、開南大學、台灣體大、中信科大和嘉義大學,8強複賽將於26日在台中開打。(編輯:陳政偉)1131218

標題:大專棒球聯賽台體預賽終戰勝輔大 晉8強隊伍確定

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。