記者孟育民/台北報導

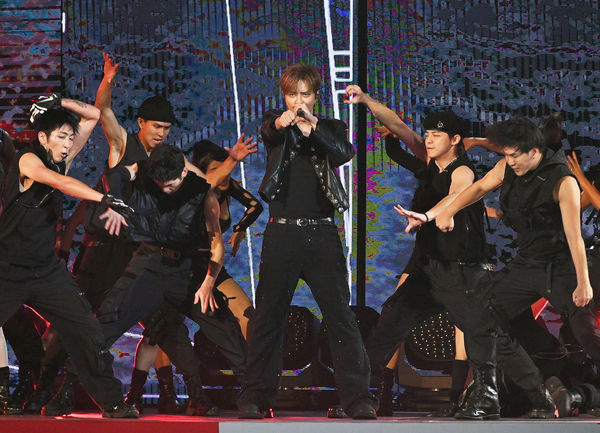

台視《2025超級巨星紅白藝能大賞》廣邀眾星齊聚一堂,陪伴觀眾迎接新春。表演前喊話要一雪前恥的「亞洲舞王」羅志祥,這次則帶來十分精採的舞台,30人舞群排舞整齊劃一氣勢驚人,〈No Joke〉和〈舞狀元〉的排場,讓亞洲天王魅力席捲《紅白》,現場滿滿粉絲熱情地揮舞著螢光棒,在全場觀眾驚喜歡呼的尖叫聲中,讓小巨蛋嗨到最高點!

此外,節目中也特別安排粉絲與偶像互動的遊戲環節,在充滿緊張與歡笑的「射龍門」遊戲中,一位追隨羅志祥長達20年的鐵粉參與,而寵粉的羅志祥也表示記得這位粉絲的職業是護理師,爽快將「撞柱」獎金加碼至6萬元,並感性地說:「感謝醫護人員的辛苦付出。」溫暖舉動感動在場所有人,而羅志祥也親自走向粉絲大方送上擁抱,這份貼心令全場熱淚盈眶,掌聲不絕於耳。

饒舌第一天團「頑童MJ116」連續兩年陪伴全台觀眾度過最嗨的除夕夜,一出場便引起全場沸騰,一連演唱〈Intro〉、〈速命道〉、〈走跳〉、〈Champagne Shower〉,毫無冷場的精彩演出讓粉絲為之瘋狂,搭配舞台及燈光效果,現場觀眾彷彿置身大型夜店。

瘦子率先送上新年祝福:「要『蛇』麼有『蛇』麼、發大財!派對像個饒舌歌手」,逗得主持人Lulu忍不住笑說:「你一口氣都講完了,請問大淵和小春怎麼辦?」,不負眾望的大淵和小春也隨即獻上蛇年祝福,大淵希望粉絲們都身體健康、「蛇」麼都行!小春則是祝大家玩遊戲時「獨當一面、『蛇』我其誰。」

標題:羅志祥認出20年護理師鐵粉!除夕節目豪發6萬紅包 暖心發聲:感謝辛苦付出

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。