▲OpenAI最近推出了ChatGPT的新功能「任務」(Tasks),讓付費用戶能夠為 ChatGPT設定排程任務,包括提醒和重複性的請求。(示意圖/pexels)

圖文/鏡週刊

OpenAI最近推出了ChatGPT的新功能「任務」(Tasks),讓付費用戶能夠為 ChatGPT設定排程任務,包括提醒和重複性的請求。這項功能目前在 ChatGPT Plus、Pro和Team計劃的用戶中推出,將有機會擴展到更多用戶。

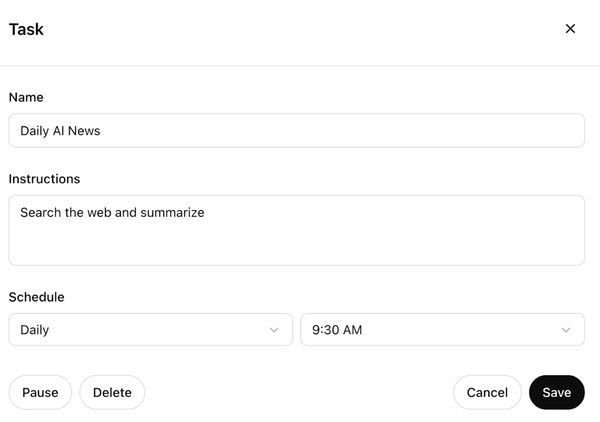

▲「任務」功能讓 ChatGPT 能夠執行特定的操作,例如設定提醒,像是「請在6個月後提醒我護照到期」或「每天早上7點給我天氣報告」。(圖/翻攝OpenAI官網)

「任務」功能讓 ChatGPT 能夠執行特定的操作,例如設定提醒,像是「請在6個月後提醒我護照到期」或「每天早上7點給我天氣報告」。此外,使用者也可以設定週期性任務,例如「每週五給我一個根據當地天氣與位置的週末計劃」或「每天早上7點給我一個新聞簡報」。

這項新功能顯示出 OpenAI 在打造更具自主能力的 AI 助手方面的努力,這種能力通常被稱為「代理性 AI」(agentic AI)。OpenAI CEO阿特曼(Sam Altman)曾表示,2025 年將是代理性 AI 的重要一年,甚至預言這些AI 可能會「進入職場」。目前,ChatGPT 的任務功能仍處於較簡單的階段,但它讓使用者能夠設定提醒,這是傳統數位助手(如Siri 或 Google Assistant)早已具備的功能。不過,ChatGPT 的任務功能加入了更多的智能與獨特性,使其在某些領域上超越了過去的數位助手。

要使用這項功能,用戶只需在 ChatGPT 的模型選單中選擇「4o with scheduled tasks」模式,然後告訴 ChatGPT希望完成的任務及時間。系統也可能根據對話內容主動建議任務,但使用者需要明確批准這些建議才能創建任務。所有任務都可以在聊天中直接管理,或透過新的「任務」管理頁面(目前僅限網頁版)來修改或取消已設定的任務。

儘管排程功能是數位助手的常見功能,但這是ChatGPT功能的一大轉變。在此之前,ChatGPT主要只處理即時請求,而非處理長期計劃或未來的任務。加入任務功能代表OpenAI擴展ChatGPT的角色,進入傳統數位助手的領域,讓其不僅僅是一個對話工具。

雖然 ChatGPT 的任務功能目前僅對付費用戶開放,但 OpenAI 可能會在未來將此功能推出給免費用戶,並根據用戶反饋進行調整。然而,目前尚未明確表示這項功能是否會在免費版本中推出。

更多鏡週刊報導

標題:ChatGPT新功能上線!進軍科技助手市場 讓AI幫排程完成任務

聲明: 本文版權屬原作者。轉載內容僅供資訊傳遞,不涉及任何投資建議。如有侵權,請立即告知,我們將儘速處理。感謝您的理解。